고해상도 이미지를 0.5초 만에 생성하는 오픈 소스 AI 이미지 생성 모델 「PixArt-δ」가 등장

Huawei Noah's Ark Lab과 대련이공대학(중국), Hugging Face 등의 연구원들이 텍스트에서 이미지를 생성하는 프레임워크「PixArt-δ(델타)」를 발표했습니다.

[2401.05252] PIXART-δ: Fast and Controllable Image Generation with Latent Consistency Models

https://arxiv.org/abs/2401.05252

Meet PIXART-δ: The Next-Generation AI Framework in Text-to-Image Synthesis with Unparalleled Speed and Quality - QAT Global

Meet PIXART-δ: The Next-Generation AI Framework in Text-to-Image Synthesis with Unparalleled Speed and Quality - QAT Global

In the landscape of text-to-image models, the demand for high-quality visuals has surged. However, these models often need to grapple with resource-intensive training and slow inference, hindering their real-time applicability. In response, this paper intr

qat.com

PixArt-δ는 이미 존재하는 1024x1024 픽셀 해상도의 이미지를 신속하게 생성하는 모델「PixArt-α(알파)」를 대폭 개량한 것으로, 1024 ×1024 픽셀의 해상도를 가지는 고화질 이미지를 불과 2~4 스텝으로, PixArt-α의 7 배 속도인 0.5초 만에 생성할 수 있습니다.

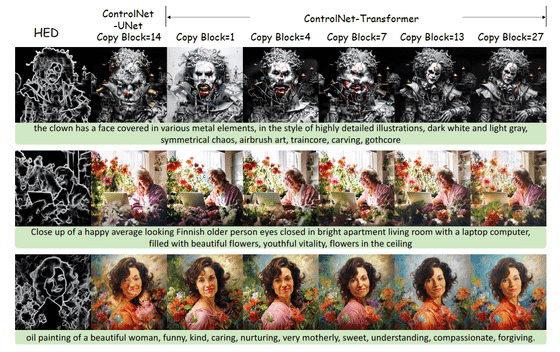

PixArt-α 모델에는, 이미지 생성 처리를 고속화하는 「Latente Consistency Model(LCM)」에 대응한 타입과, 포즈나 심도등의 정보를 추가로 주어 품질을 향상하는 「ControlNet」에 대응한 타입의 2개가 있었습니다만, δ모델에서는 「ControlNet-Transformer」라는 아키텍처를 채용해, 각각의 유효성을 유지하면서 2개를 통합했다고 합니다.

δ모델은 아직 리포트만 공개된 것으로, 데모판 등은 아직 공개되어 있지 않습니다만, 이전부터 공개된 α모델의 LCM 타입과 ControlNet 타입은 아래의 링크에서 액세스 할 수 있습니다.

PixArt LCM - a Hugging Face Space by PixArt-alpha

PixArt LCM - a Hugging Face Space by PixArt-alpha

huggingface.co

PixArt-alpha/PixArt-ControlNet · Hugging Face

PixArt-alpha/PixArt-ControlNet · Hugging Face

No model card New: Create and edit this model card directly on the website! Contribute a Model Card

huggingface.co

LCM 유형은 텍스트 프롬프트를 영어로 입력하여 이미지를 생성합니다.

긴 프롬프트라면 생성에 10초 이상 걸립니다.

δ판은 생성에 걸리는 시간이 최단 0.5초로, α판의 몇 배나 빨라졌습니다.

보고서에서는 PixArt-δ(왼쪽)과 2~8단계로 이미지를 생성할 수 있는 LCM SDXL(오른쪽)을 비교한 이미지도 공개되어 있습니다. PixArt-δ 쪽이 약간 해상도가 높은 인상.

트레이닝 효율도 향상되어, 32GB의 GPU 메모리 제약 내에서 학습 프로세스를 성공시키고 있다는 것으로, 이 효율성에 의해 「컨슈머 그레이드」의 GPU에서도 학습이 가능하다는 것. 또한, 가중치가 많을수록 완성도가 떨어지는 문제가 기존 모델에서 보였지만, ControlNet-Transformer를 채용한 PixArt-δ에서는 그 문제를 개선하는 데 성공했다고 합니다.

AI 녀석...

점점 생성 속도가 빨라지고 있네요