AI 모델을 누구나 쉽게 배포할 수 있는 사이트 "Replicate"에서 이미지를 분석하여 캡션을 생성하는 AI 모델 BLIP-2를 쉽게 사용할 수 있다고 하여, 실제로 일부 이미지를 바탕으로 캡션을 생성해 보았습니다.

LAVIS/projects/blip2 at main · salesforce/LAVIS

https://github.com/salesforce/LAVIS/tree/main/projects/blip2

andreasjansson/blip-2 – Run with an API on Replicate

Replicate

Run open-source machine learning models with a cloud API

replicate.com

먼저 Replicate 사이트로 이동하여 오른쪽 상단의 Sign in을 클릭합니다.

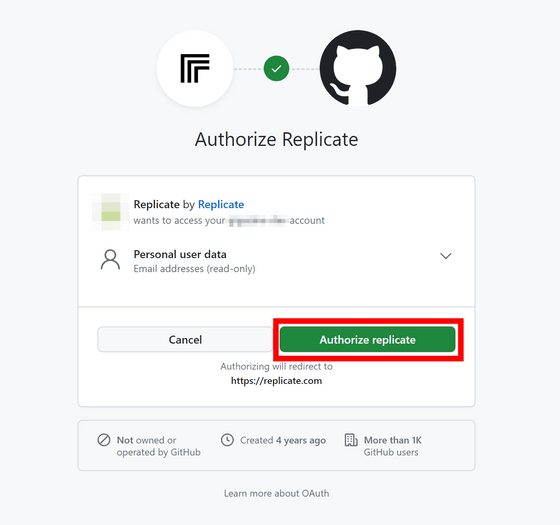

Replicate에 로그인하려면 GitHub 계정이 필요합니다. Sign in with GitHub를 클릭합니다.

권한을 확인하고 Authorize replicate를 클릭합니다.

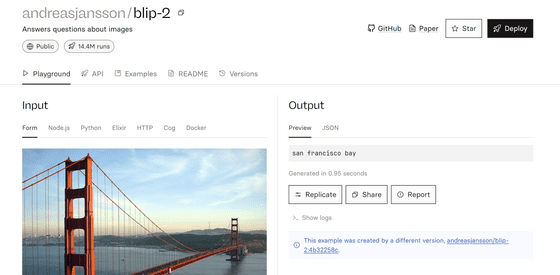

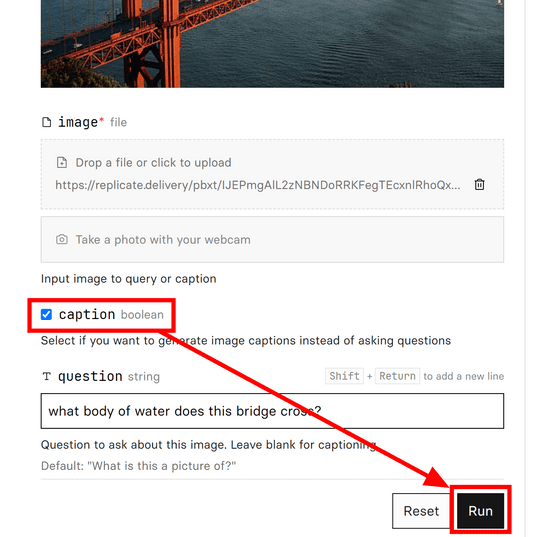

로그인하면 BLIP-2 페이지를 엽니다. 처음엔 데모용 이미지로 샌프란시스코의 금문교가 나타납니다.

페이지를 아래로 스크롤하면 "caption"이라는 옵션이 존재합니다. BLIP-2에서는 이미지를 바탕으로 질문하는 사용법도 가능합니다만, 이번은 캡션을 붙이고 싶기 때문에 「caption」을 On으로 해, 「Run」을 클릭해 실행합니다.

"golden gate bridge, san francisco, california"와 캡션이 부여되었습니다.

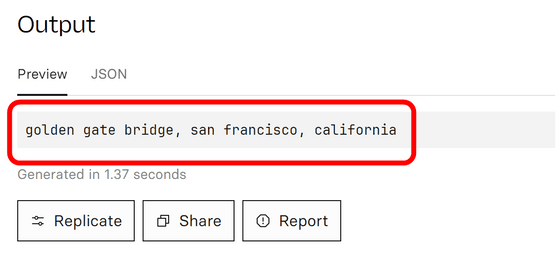

이미지 하단에 있는 "Drop a file or click to upload"라고 적힌 프레임 안에 이미지를 드래그 앤 드롭하여 소장하고 있는 이미지에 캡션을 붙일 수도 있습니다.

테스트로 아래의 이미지를 입력해 보니, "a woman sitting in the back of a pickup truck with her mouth open(픽업트럭 뒤에 앉아 입을 벌리고 있는 여성)"이라는 캡션이 생성되었습니다.

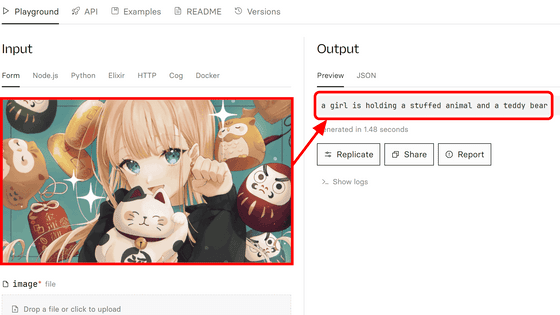

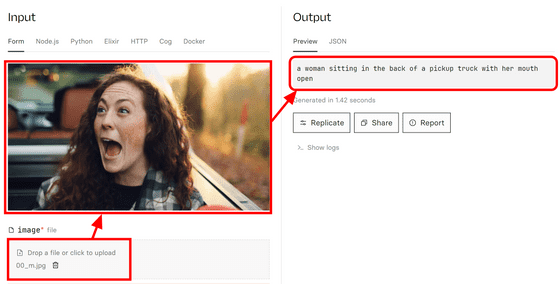

일러스트에서도 캡션을 붙일 수 있습니다. 다만, BLIP-2가 생성한 캡션은 「a girl is holding a stuffed animal and a teddy bear(봉제인형과 테디 베어를 안은 소녀)」라고 나와, 테디 베어라는 잘못된 정보가 부여되어 버렸습니다.

이번 캡션을 붙이는 데모에는 BLIP2_OPT_6.7B 모델이 이용되고 있습니다. 이 모델은 MIT 라이선스로 제공되고 있기 때문에 무료로 사용할 수 있고 상용 이용도 가능합니다.

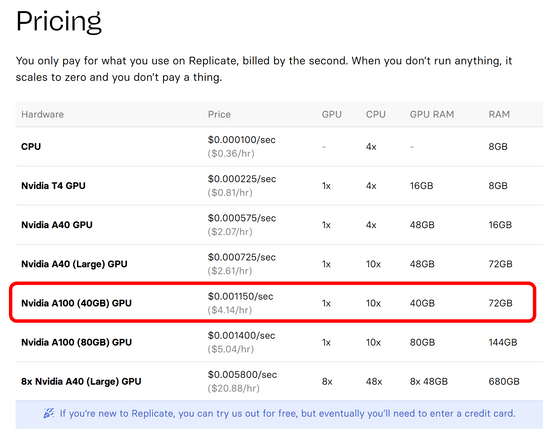

그러나 Replicate에는 사용료가 필요합니다. Replicate는 어느 정도는 「테스트」로서 무료 사용 가능하지만, 일정 시간을 넘으면 추론에 걸린 시간 초당 0.001150달러의 비용이 듭니다. 사전에 신용카드를 등록할 필요는 없고, 추론할 수 없게 되고 나서 등록하면 됩니다. 「어느 정도까지 무료로 이용할 수 있을지」에 대해서는 기재되어 있지 않습니다.

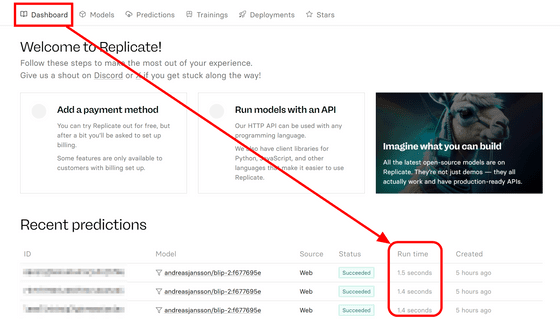

"각각의 추론에 몇 초가 걸렸는가"에 대해서는 Replicate의 대시보드를 열면 확인할 수 있기 때문에, 비용의 기준을 견적 내기 쉬운 편입니다. 이번에는 3회의 추론으로 합계 4.3초 걸렸기 때문에, 비용은 약 6.4원이었습니다.

'AI · 인공지능 > AI 뉴스' 카테고리의 다른 글

| NVIDIA의「Align Your Gaussians(AYG)」 : 텍스트로 동적 4D 장면을 생성 (84) | 2024.01.11 |

|---|---|

| 아이디어를 몇 단어로 지시하면 AI가 음악을 생성해주는 Google 「MusicFX」 (81) | 2024.01.11 |

| Microsoft가 30년 만에 표준 키보드에 새로운 키를 추가, AI 툴에 액세스하는 「Copilot 키」가 등장 (84) | 2024.01.10 |

| 단어와 소리를 오디오 형식으로 변환하는 AI 「Amphion」 테일러 스위프트가 부르는 중국 노래를 생성 (79) | 2024.01.09 |

| 라파엘로의 그림은 공동 제작이었을 가능성이 AI를 사용한 연구에서 분명히 (94) | 2023.12.26 |

| Apple이 이미지를 보고 질문에 답할 수 있는 대규모 언어 모델 'Ferret'을 개발 (80) | 2023.12.26 |

| Facebook은 이미 AI가 만든 가짜 게시물로 가득 차 있다 (103) | 2023.12.21 |

| Microsoft가 LLM의 입력 프롬프트의 의미를 유지하면서 고도로 압축하는 기술「LLMLingua」를 개발 (94) | 2023.12.20 |