Meta의 대규모 언어 모델「LLaMA-65B」의 데이터가 4chan로 유출

Meta가 2023년 2월에 발표한 대규모 언어 모델「LLaMA」는 GPT-3와 필적하는 성능을 가지며, 단품의 GPU에서도 동작 가능할 정도로 가볍기 때문에, 소비자 레벨의 하드웨어 환경에서도 ChatGPT 같은 AI를 움직일 수 있게 될 것으로 기대되고 있습니다. 그런 LLAMA의 데이터가 유출되어 화제가 되고 있습니다.

Facebook LLAMA is being openly distributed via torrents | Hacker News

https://news.ycombinator.com/item?id=35007978

OpenAI의 ChatGPT와 DeepMind의 Chinchilla 등 기존의 대규모 언어 모델을 동작시키기 위해서는 AI에 최적화된 가속기를 여럿 사용할 필요가 있었지만, LLAMA는 단독 GPU에서도 충분히 동작이 가능하며, 모델의 규모를 나타내는 파라미터 수도 압도적으로 적다는 것이 이점입니다. 현시점에서는 모델 데이터의 일부가 GitHub에서 공개되고 있으며 Meta AI Research에 연락하면 신경망에서 학습한 '가중치'를 별도로 다운로드할 수 있습니다.

Meta가 대규모 언어 모델「LLaMA」를 발표, GPT-3에 필적하는 성능으로 단일 GPU에서도 동작

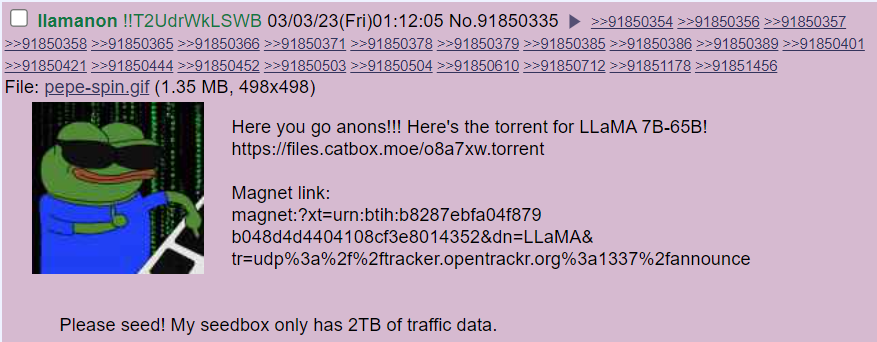

그러나 4chan에서 AI 채팅봇에 대해 말하는 스레드 중 2023년 3월 3일에 'llamanon !! T2UdrWkLSWB'라는 사용자가 갑자기 LLAMA-65B(매개변수 수 650억)의 '가중치' 데이터를 다운로드 가능한 토렌트 파일과 마그넷 링크를 공개했습니다.

https://boards.4channel.org/g/thread/91848262#p91850335

/g/ - /aicg/ - AI Chatbot General - Technology - 4chan

boards.4channel.org

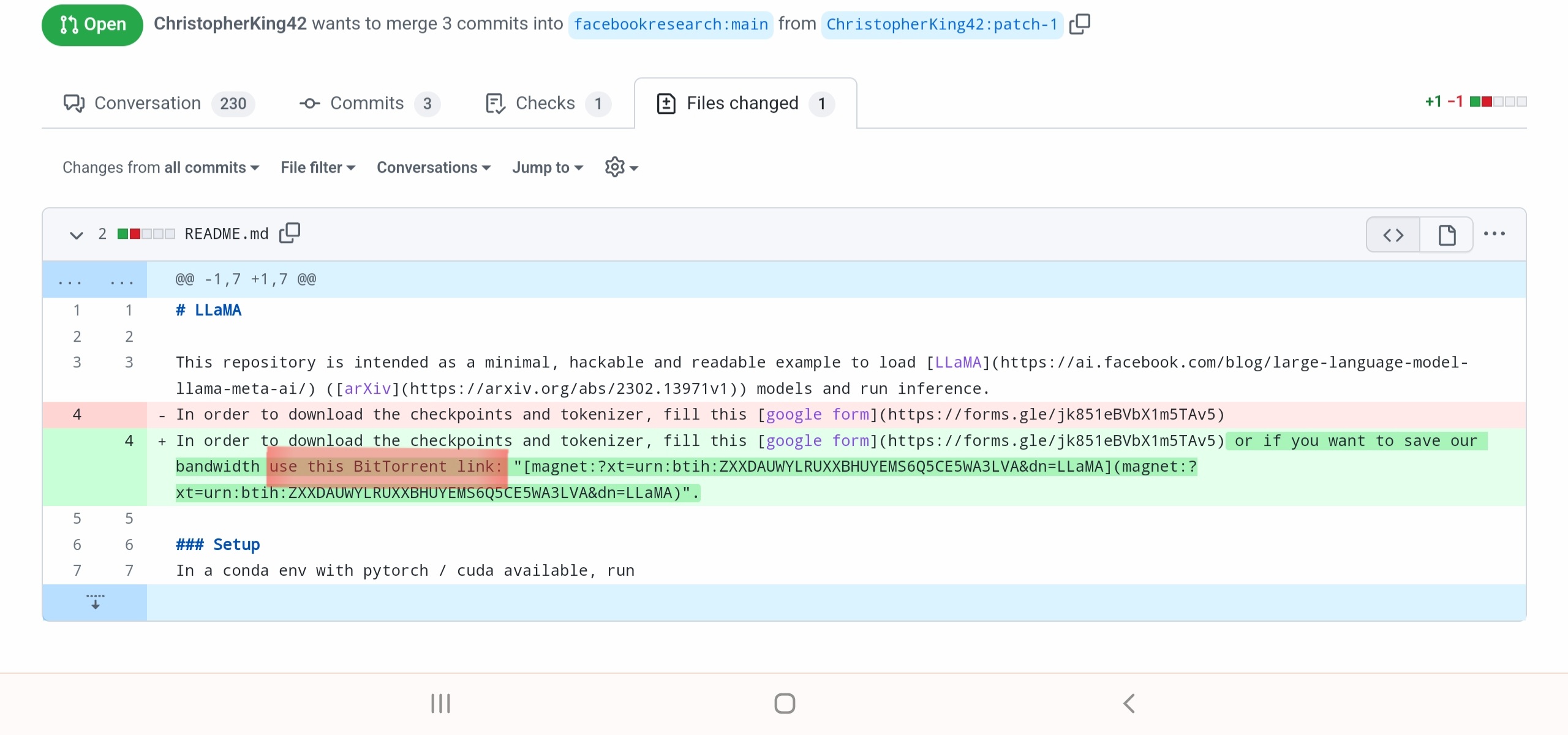

또한 GitHub에 위치한 LLAMA의 리포지토리는 4chan에 게시된 마그넷 링크 추가가 Pull Request되고 있습니다.

Save bandwidth by using a torrent to distribute more efficiently by ChristopherKing42 · Pull Request #73 · facebookresearch/llama · GitHub

https://github.com/facebookresearch/llama/pull/73/files

Save bandwidth by using a torrent to distribute more efficiently by ChristopherKing42 · Pull Request #73 · facebookresearch/ll

github.com

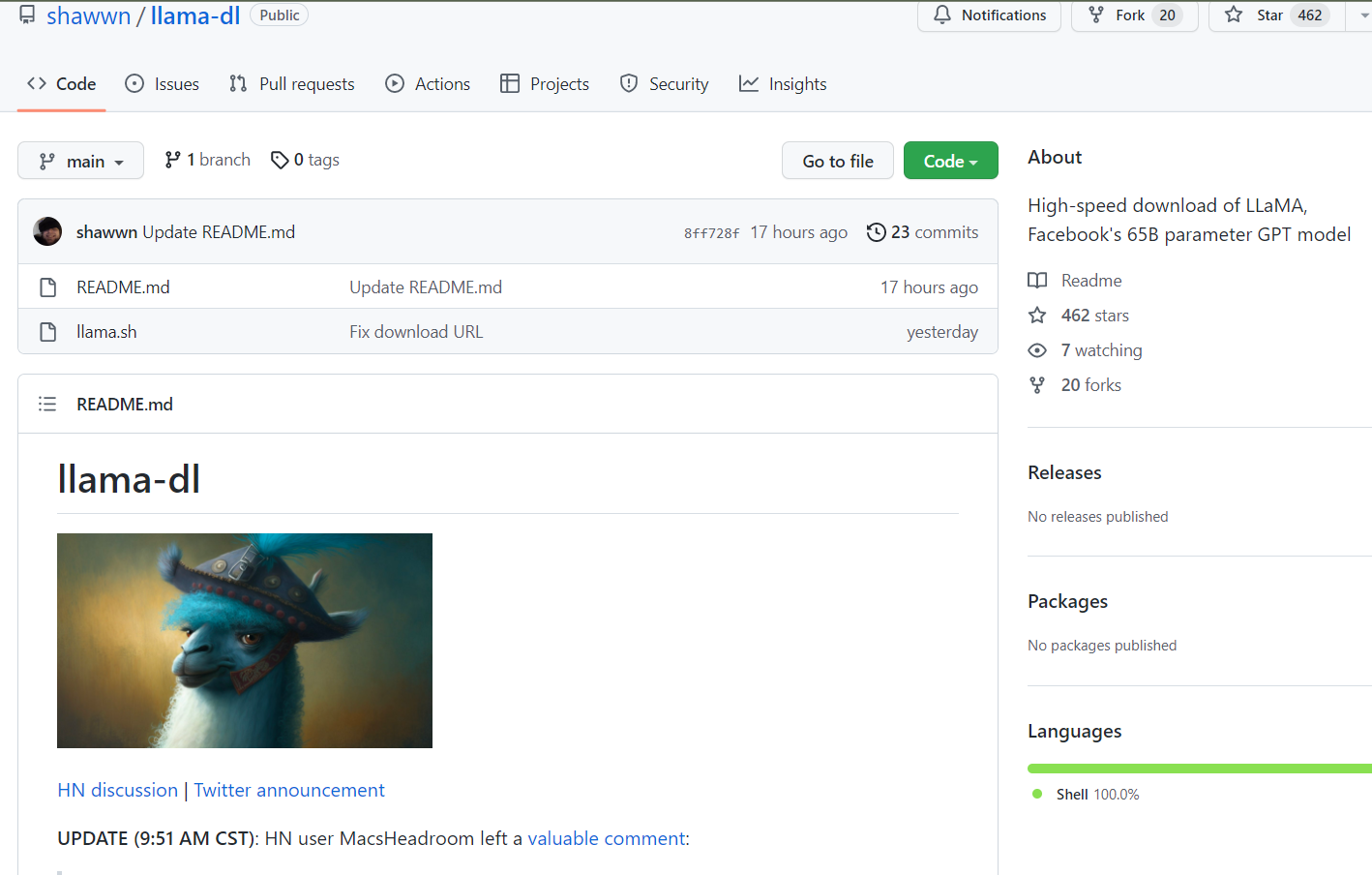

또한, 이 유출된 LLAMA의 가중치 데이터를 기반으로 LLAMA의 7B(매개 변수 수 70 억) · 13B(매개 변수 수 130 억) · 30B(매개 변수 수 300 억) · 65B의 가중치 데이터를 40MB/s로 다운로드할 수 있는 다운로더가 GitHub에 게시되었습니다.

GitHub - shawwn/llama-dl: High-speed download of LLaMA, Facebook's 65B parameter GPT model

https://github.com/shawwn/llama-dl

GitHub - shawwn/llama-dl: High-speed download of LLaMA, Facebook's 65B parameter GPT model

High-speed download of LLaMA, Facebook's 65B parameter GPT model - GitHub - shawwn/llama-dl: High-speed download of LLaMA, Facebook's 65B parameter GPT model

github.com

다운로더를 공개한 숀 프레서 씨는 "LLAMA의 가중치 데이터 누출이 위험하다고 주장하는 사람들이 이미 나오고 있습니다. 그러나 GPT-2의 1.5B(파라미터 수 15억) 모델이 누설되었을 때도 모두 같은 말을 했었습니다. 실제로 GPT-2의 커다란 매력이 2019년 제가 기계 학습에 진지하게 임하게 하는 원동력이 되었습니다. 그로부터 4년이 지난 2023년이 되어, GPT-2의 누설 모델에 대해서는 더 이상 아무도 신경 쓰지 않으며, 광범위한 사회적 피해도 없었다는 것이 확실해졌습니다. LLaMA도 이와 마찬가지입니다."라고 댓글을 달고 있습니다.

관련글

오프라인으로 AI와 채팅하는「Alpaca.cpp」로컬 설치 리뷰

2023년 3월, 스탠포드 대학이 ChatGPT와 동등한 성능을 가진 채팅 AI 모델 'Alpaca'를 공개했습니다. 이 Alpaca를 자신의 PC에 설치하여 로컬에서 채팅 AI를 돌리는 「Alpaca.cpp」 가 등장했으므로, 그 설치

doooob.tistory.com

무료로 상용 이용도 가능한 완전 오픈소스 대규모 언어 모델 「RedPajama」가 트레이닝 데이터 세

OpenAI의 GPT-4와 같은 대규모 언어 모델을 통해 AI 기술이 빠르게 확산되고 있습니다. 그러나 GPT-4를 비롯한 대규모 언어 모델 중 상당수가 폐쇄형 상용 모델이거나 부분적으로만 공개되어 있습니

doooob.tistory.com