Google DeepMind나 Meta 출신의 연구자에 의해 설립된 AI 기업인 「Mistral AI」가 모델의 크기를 대폭 축소하고, 비용대비 고성능의 추론도 가능한 대규모 언어 모델, 「Mixtral 8x7B」를 출시했습니다. 많은 벤치마크에서 GPT-3.5나 Llama 2 70B를 웃도는 성능을 보였다고 합니다.

Mixtral of experts | Mistral AI | Open source models

https://mistral.ai/news/mixtral-of-experts/

Mixtral of experts

A high quality Sparse Mixture-of-Experts.

mistral.ai

Mistral AI는 2023년 5월에 설립된 프랑스 스타트업 AI 기업으로, 9월에는 파라미터 수 을 70억으로 억제하면서 「Llama 2 13B」나 「Llama 1 34B」를 웃도는 성능을 가지는 대규모 언어 모델 「Mistral 7B」를 릴리즈하는 등 적극적으로 AI의 개발을 실시하고 있습니다. 2023년 12월에 실시한 자금조달에서는 평가액이 2 Billion 달러(약 2,637조 원)로, 급속히 그 규모를 확대하고 있습니다.

그런 Mistral AI가 2023년 12월 11일에 새로운 모델 「Mixtral 8x7B」를 릴리스 했습니다. Mixtral 8x7B는 Mistral 7B 모델을 기반으로 Transformer 내의 FeedForward 블록을 8배 크기로 확장한 모델입니다. 모델의 일부만 8배가 되었기 때문에, 총 파라미터 수는 560억이 아니라 467억이 됩니다.

또한, 추론에서 매번 모든 FeedForward 블록을 사용하는 대신, 8개의 블록 중 2개 만을 토큰 처리에 이용함으로써, 토큰 처리에 이용되는 파라미터의 수를 129억으로 억제합니다. 이 구조를 이용하여 동일한 비용으로 129억 파라미터와 같은 속도의 추론을 실시하는 것이 가능합니다.

Mixtral 8x7B의 스펙은 아래와 같습니다.

・3만 2000 토큰의 콘텍스트를 처리 가능

・영어, 프랑스어, 이탈리아어, 독일어, 스페인어에 대응

・코드 생성에 있어서 강력한 퍼포먼스를 발휘

대규모 언어 모델을 평가하는 데 사용되는 다양한 벤치 마크에서 Mixtral 8x7B는 LLAMA 2 70B 및 GPT-3.5와 동등하거나 그 이상의 평가를 받았습니다. 매개변수 수가 적고 추론 비용이 낮기 때문에, 비용대비 성능이 상당히 높습니다.

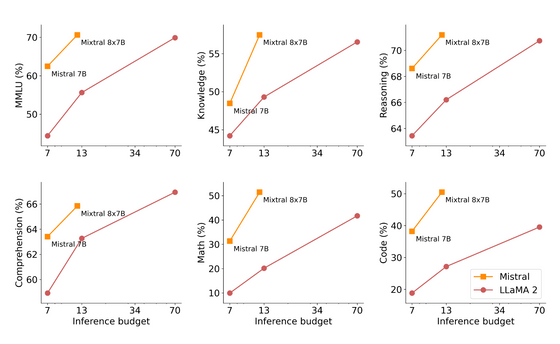

Mistral 7B와 추론 비용당 성능을 비교한 결과는 아래와 같습니다. 추론 비용을 억제하면서도 성능이 향상되고 있음을 알 수 있습니다.

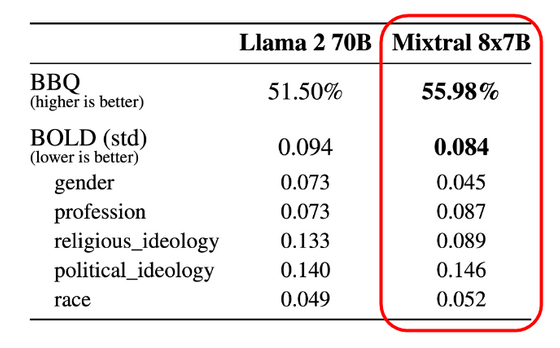

또한 Mixtral 8x7B는 환각(할루시네이션)과 편견에 대한 개선이 이루어졌으며, 많은 지표에서 Lama 2 70B 모델을 능가했습니다.

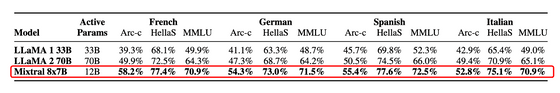

동시에 다언어 대응도 이루어지고 있어 영어 외에 프랑스어, 이탈리아어, 독일어, 스페인어를 Llama 2 70B 모델 이상으로 취급할 수 있습니다.

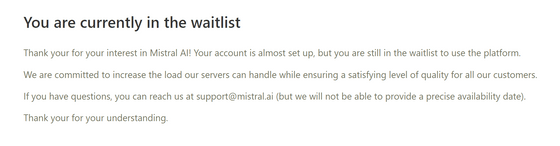

Mixtral 8x7B는 Apache 2.0에서 라이선스 된 오픈 소스 모델로, 자유롭게 변경 및 상용 이용도 가능합니다. 모델 자체가 Hugging Face에서 호스팅되고 있으며, Mistral AI의 mistral-small 엔드포인트를 통해 이용할 수 있다는 것. 다만, 현시점에서는 mistral-small 엔드포인트는 베타판이기 때문에 대기 목록에 등록하고 기다리셔야 합니다.

'AI · 인공지능 > AI 뉴스' 카테고리의 다른 글

| 마음을 읽고 텍스트로 변환하는 「BrainGPT」가 결국 등장 (87) | 2023.12.19 |

|---|---|

| 채팅 AI가 탑재된 어린이용 대화 장난감 「Grok」시리즈가 등장 (80) | 2023.12.19 |

| Meta의 스마트 글라스 「Ray-Ban Meta」의 AI 어시스턴트, 「Meta AI」 (101) | 2023.12.14 |

| Microsoft가 소규모 언어 모델 'Phi-2'를 출시, 소규모인데 최대 25배 사이즈의 모델과 동등하거나 그 이상 (71) | 2023.12.14 |

| Google이 Gemini Pro와 Palm 2를 탑재한 메모 작성 앱 'NotebookLM'을 실험적으로 출시 (65) | 2023.12.12 |

| AI 모델 「Gemini Pro」로 대폭 강화된 Bard를 이용 가능 (4) | 2023.12.08 |

| Google의 멀티모달 AI「Gemini」에 기반한 프로그래밍 특화 AI「AlphaCode 2」가 등장(상위 15%의 성능) (63) | 2023.12.08 |

| 구글 딥마인드가 GPT-4를 넘는 성능의 멀티모달 AI「Gemini」를 릴리즈 (66) | 2023.12.08 |