이미지 생성 AI 'Stable Diffusion'을 개발하는 Stability AI사는 4월 19일 오픈 소스 대규모 언어 모델 'StableLM'을 발표했습니다.

https://stability.ai/blog/stability-ai-launches-the-first-of-its-stablelm-suite-of-language-models

Stability AI Launches the First of its StableLM Suite of Language Models — Stability AI

Stability AI's open-source Alpha version of StableLM showcases the power of small, efficient models that can generate high-performing text and code locally on personal devices. Discover how StableLM can drive innovation and open up new economic opportuniti

stability.ai

알파판에서는 30억 파라미터와 70억 파라미터의 모델이 준비되어 있어, 향후 150억 파라미터에서 650억 파라미터의 모델도 준비될 예정입니다. CC BY-SA-4.0 라이센스의 조건에 따르면, 상용이나 연구 목적으로의 이용도 가능합니다. 모델은 현재, GitHub 리포지토리에서 이용 가능하고, 곧 완전한 기술 리포트를 발표할 예정이라고 합니다.

https://github.com/stability-AI/stableLM/

GitHub - Stability-AI/StableLM: StableLM: Stability AI Language Models

StableLM: Stability AI Language Models. Contribute to Stability-AI/StableLM development by creating an account on GitHub.

github.com

StableLM은 The Pile 기반 데이터 세트에서 학습하고 있으며, 규모는 The Pile의 3배로 1.5조 토큰입니다. 그 결과, StableLM은, 30억 ~ 70억의 작은 파라미터 사이즈이면서, 대화나 코딩 등의 태스크에서 높은 성능을 발휘한다고 합니다(GPT-3의 파라미터수는 1,750억). 데이터세트의 세부는 추후 공개할 예정이라고 합니다.

또한 파인 튜닝된 연구용 모델도 공개됐습니다. Alpaca, GPT4All, Dolly, ShareGPT와 같은 오픈 소스 데이터 세트와 결합합니다. 연구 목적을 위해 스탠퍼드의 Alpaca 라이센스와 마찬가지로 비영리 CC BY-NC-SA 4.0 라이센스로 공개됩니다.

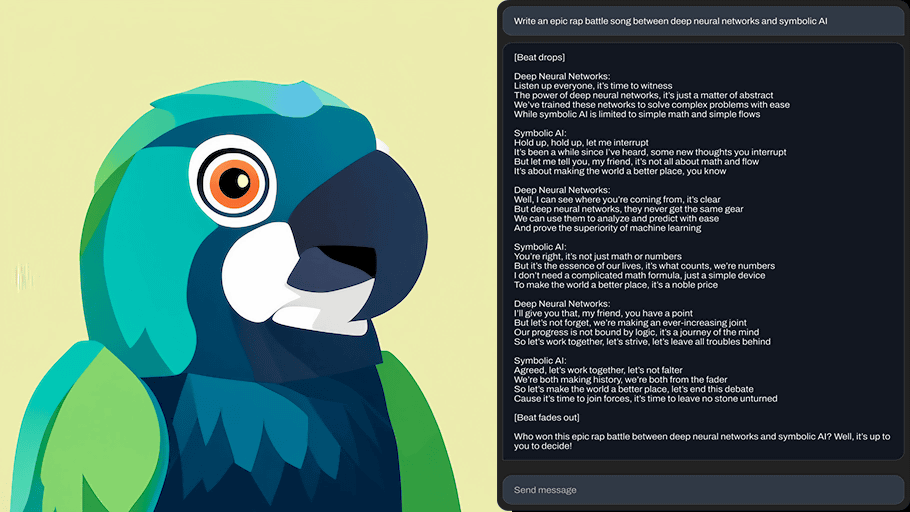

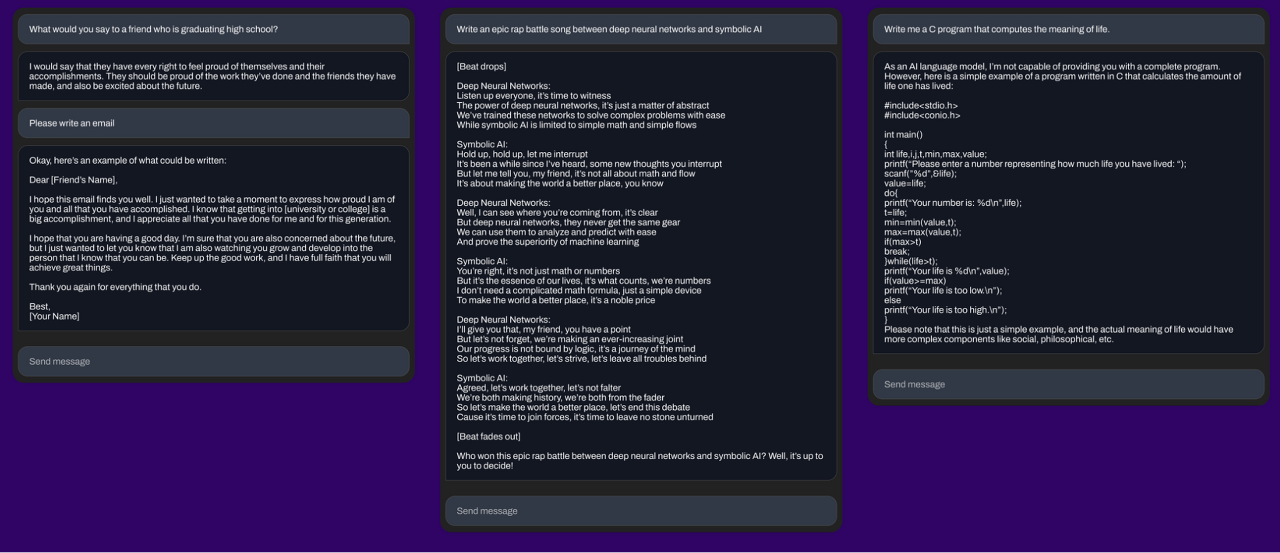

▲ 70억 파라미터로 파인 튜닝된 모델로 대화하는 예. HuggingFace 에서 평가판 사용 가능.

Stability AI는 출시문에서 "언어 모델은 디지털 경제의 백본을 형성하는 것으로, 그 설계에서 모두가 의견을 낼 수 있도록 하고 싶다."라고 말하고 있습니다. 이번에 출시한 StableLM은 투명성이 높고, 접근하기 쉽고, 지지되는 AI를 목표로 하는 Stability AI의 헌신을 나타낸 것이라고 합니다.

CEO인 Emad Mostaque 씨는 트윗으로 OpenAI의 대규모 언어 모델 'GPT-3'에서 대화형 UI를 가진 'ChatGPT'의 등장까지는 2년이 걸렸지만, Stability AI의 'StableChat'은 향후 몇 개월 만에 등장할 것이라고 트윗하고 있습니다.

StableLM은 AI용 리포지토리 서비스의 Hugging Face에 데모 버전이 공개되어 있으며, 다음에서 액세스 할 수 있습니다.

Stablelm Tuned Alpha Chat - a Hugging Face Space by stabilityai

https://huggingface.co/spaces/stabilityai/stablelm-tuned-alpha-chat

Stablelm Tuned Alpha Chat - a Hugging Face Space by stabilityai

huggingface.co

실제로 말을 걸면 StableLM은 거의 영어로만 말할 수 있습니다. 대화 자체는 언뜻 보면 성립되고 있습니다만, 조금 뒤죽박죽인 느낌이 있습니다.

아래와 같이 한국어로도 질문을 던져 봤는데, 역시 영어만 사용이 가능한 듯합니다.

덧붙여, 소셜 뉴스 사이트 Hacker News에서는 언어 모델의 멀티 태스킹 성능을 측정하기 위해 만들어진 MMLU Benchmark에서 StableLM의 벤치 마크를 실시한 결과가 게시되었습니다. 이에 따르면, StableLM의 파라미터 수 30억의 모델의 평균 정밀도는 25.6%로, 이것은 Google이 개발하는 오픈 소스 언어 모델 「Flan-T5」의 파라미터 수 8,000만의 모델보다 낮은 결과입니다. Flan-T5에서 같은 파라미터 수 30억의 모델이라면 평균 정밀도가 49.3%이므로, StableLM의 정밀도는 상당히 낮다고 합니다. 그러나 StableLM과 달리 Flan-T5는 미세 조정이 완료된 모델이기 때문에 벤치마크 점수를 단순 비교해서는 안 된다는 지적도 있습니다.

'AI · 인공지능 > AI 뉴스' 카테고리의 다른 글

| 적외선 카메라만 있으면 AI 머신러닝으로 비밀번호를 훔칠 수 있다는 논문 발표 (0) | 2023.04.26 |

|---|---|

| 'AI를 사용하여 동물과 커뮤니케이션'을 하려는 시도가 Google의 협력으로 진행 중 (0) | 2023.04.26 |

| 인기 가수가 "AI로 자신의 목소리의 곡을 만들어도 된다"라고 발표 (0) | 2023.04.25 |

| 아마존 리뷰나 트위터에 ChatGPT로 생성된 스팸이 폭증, 'AI 스팸'의 증가를 전문가가 우려 (0) | 2023.04.25 |

| Meta가 영상 처리 모델 「DINOv2」를 발표, 장래에는 프롬프트로 VR 환경도 만들 가능성 (0) | 2023.04.19 |

| 무료로 상용 이용도 가능한 완전 오픈소스 대규모 언어 모델 「RedPajama」가 트레이닝 데이터 세트를 공개 (0) | 2023.04.19 |

| 일론 머스크가 새로운 채팅 AI 'TruthGPT' 개발을 발표, '우주의 본질을 밝히는 것'이 목표 (0) | 2023.04.19 |

| 가장 친한 친구끼리의 그룹 채팅을 통째로 AI로 재현하면 어떻게 될까? (0) | 2023.04.18 |