미국 마이크로소프트는 2023년 8월 7일 공식 블로그에서 'AI 레드팀' 실천에 관한 지식을 공개했습니다.

Microsoft AI Red Team building future of safer AI | Microsoft Security Blog

Microsoft AI Red Team building future of safer AI | Microsoft Security Blog

We’re sharing best practices from our team so others can benefit from Microsoft’s learnings. These best practices can help security teams proactively hunt for failures in AI systems, define a defense-in-depth approach, and create a plan to evolve and g

www.microsoft.com

자사의 AI를 굳이 공격하는 조직을 만들어, 보안상의 약점을 찾아낸다는 것입니다.

사이버 보안의 세계에서는 시스템 방어역 「Blue Team(블루 팀)」과는 별도로 공격역 「Red Team(레드 팀)」을 만들고, 모의적으로 싸우게 하여 약점을 찾아, 진짜로 공격당하기 전에 대책을 세우는 수법이 확산되고 있습니다.

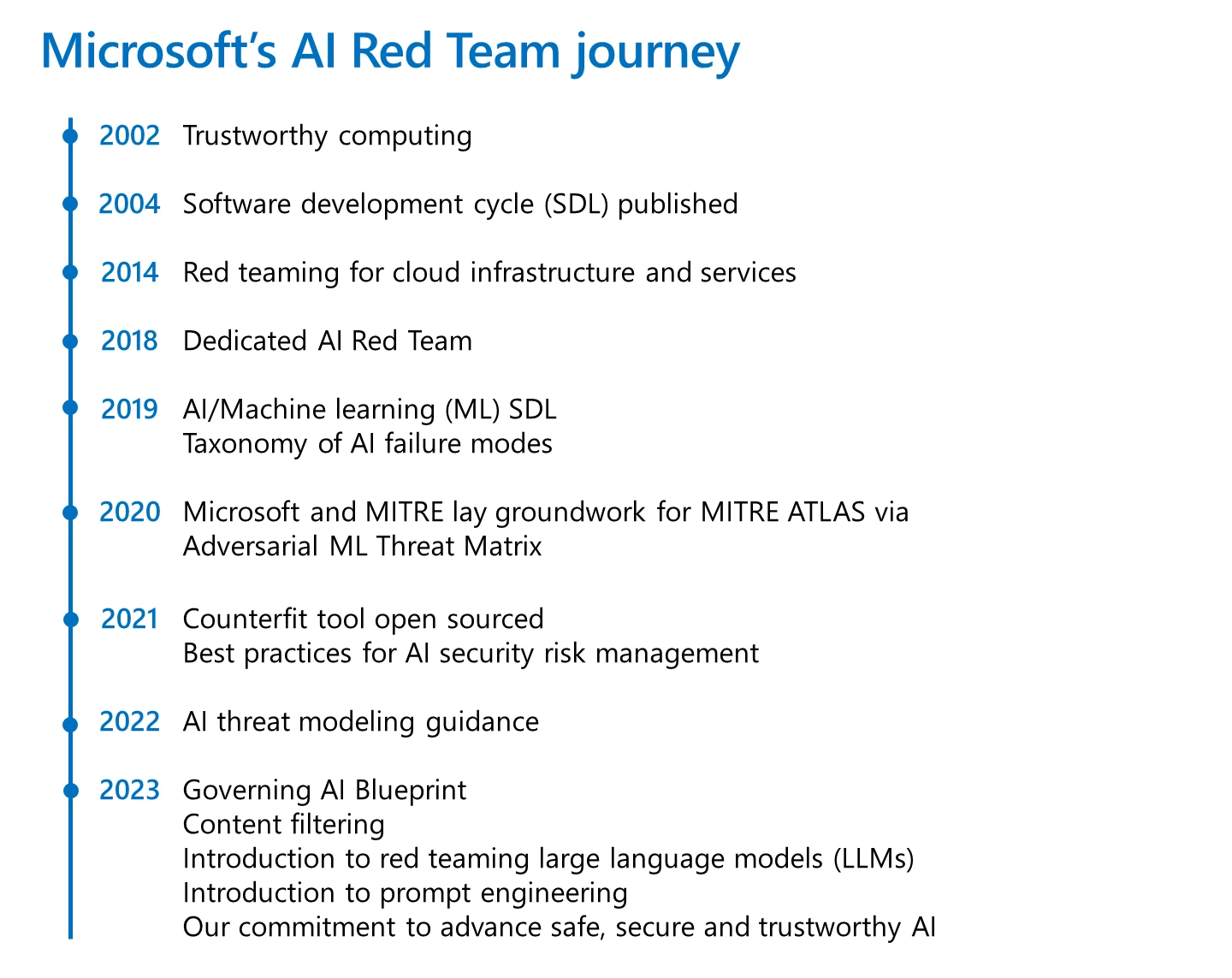

MS는 2018년부터 'AI 레드팀'을 움직여 자사의 AI 등의 약점을 찾고 있습니다. 예를 들어 생성 AI 검색 'Bing AI Chat(새로운 Bing)'을 공개하기 전에 사내에서 수십 명의 보안 인력과 책임 있는 AI(Responsible AI, RAI) 전문가로 AI 레드팀을 만들어 수백 시간에 걸쳐 조사를 진행했습니다. 이런 경우에는 Bing AI Chat과 같은 애플리케이션과 배후에서 움직이는 대규모 언어 모델(LLM) 'GPT-4'를 모두 대상으로 하여, 2단계로 임할 필요가 있다고 합니다.

우선 GPT-4에 대한 공격으로 약점이나 한계를 찾는 것은 GPT-4 그 자체의 개량에 도움이 될 뿐만 아니라, 어떤 앱에 적합한가를 파악하는 데 있어서도 유익 헸습니다. Bing AI Chat을 향한 공격은 GPT-4를 검색에 탑재해도 장애가 일어나지 않는지 확인할 수 있었습니다.

Microsoft는 경험을 살려, AI 레드 팀이 기존의 레드 팀과 어디가 비슷하고, 어디가 다른지를 보안 전문가의 용어로 설명하고 있으며, 더 많은 조직에서 AI 레드팀을 만들고 잘 활용할 수 있도록 하기 위한 노하우 5가지를 소개하고 있습니다.

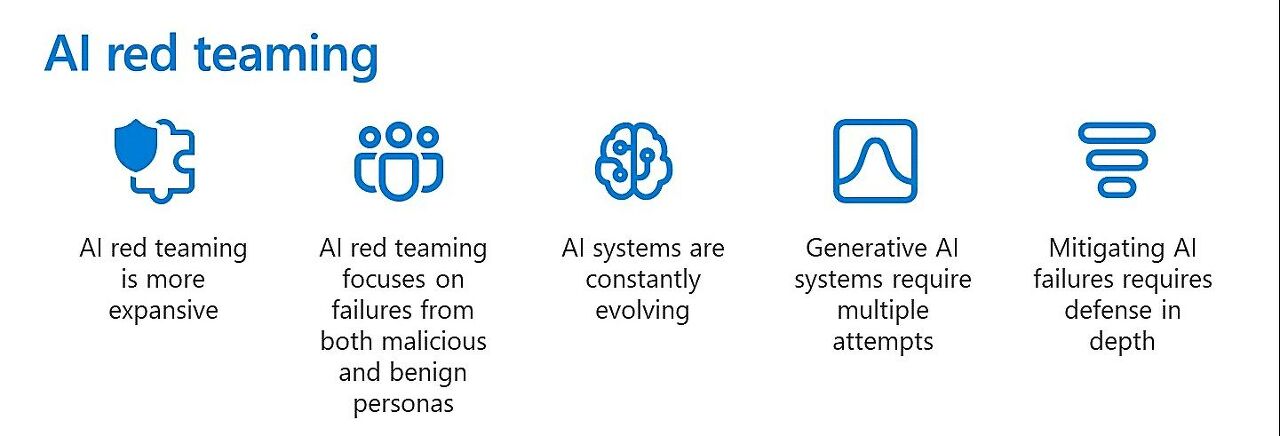

1. AI 레드팀의 역할은 보다 광범위하다

2. AI 레드팀은 악의적인 인물뿐만 아니라 선의의 인물이 일으키는 문제에도 주목

3. AI는 지속적으로 진화하고 있다

4. 생성 AI는 여러 번의 시도가 필요

5. AI 문제를 완화하려면 다중 방어가 필요

1. AI 레드팀의 역할은 보다 광범위하다

AI 레드팀은 기존의 레드팀과 달리 보안 취약성뿐만 아니라 RAI 문제를 다루어야 한다. AI가 나타내는 다양한 고정관념 등 공평성 문제와 폭력성 찬양을 비롯한 유해한 정보에 대해서도 조사할 필요가 있다.

2. AI 레드팀은 악의적인 인물뿐만 아니라 선의의 인물이 일으키는 문제에도 주목

예를 들어 새로운 Bing에서는 악의적인 인물이 보안에 중점을 둔 기술이나 악성 프로그램으로 AI를 파괴할 가능성뿐만 아니라, 일반인이 어떻게 AI와의 대화로 유해 정보를 생성하는지에도 주목해야 한다. 이 점이 악인의 행동에만 주목하는 기존의 레드팀과는 다르다. AI 레드팀에서는 보다 광범위한 페르소나(부캐릭터)를 대상으로 한다.

3. AI는 지속적으로 진화하고 있다

AI 항시 변화한다. LLM의 경우 개발자는 피드백에 따라 메타 프롬프트(기계 학습 모델에 대한 기본 명령)를 변경할 수 있다. 전통적인 소프트웨어 시스템에 비해 AI는 급속히 변화하기 때문에 AI 레드팀은 공격을 반복하여 체계적이고 자동화된 측정 시스템을 확립하고, 시간을 들여 감시하는 것이 중요하다.

4. 생성 AI에 대해 여러 번의 시도가 필요

생성 AI의 행동은 확률에 따라 결정되며 동일한 입력을 여러 번 실행하면 다른 출력을 얻을 수 있다. AI 레드팀도 같은 조작으로 여러 번의 공격을 실시할 필요가 있다. 첫 번째 공격이 실패해도 다음번 이후의 동일한 공격이 성공해 버리는 경우를 고려해야 한다. 공격에 대한 결과만이 결정적 부분이 되는 기존의 레드팀은 다르다.

5. AI 문제를 완화하려면 다중 방어가 필요

AI에서 발생하는 문제를 완화하기 위해서는 단일 방법이 아닌 여러 수단을 결합해야 한다. 잠재적으로 유해한 정보를 표시하기 위해 AI 분류기(Classifier)를 사용한다거나, 인간과의 상호 작용이 위험한 방향으로 벗어나지 않도록 "메타 프롬프트"를 사용하여 행동을 유도하는 것도 포함한다. 다중 방어가 중요하다는 점에 있어서는 기존의 레드팀과 비슷하다.

관련글

Google이 AI를 공격하는 6가지 방법을 공개, 개인정보 추출부터 AI 자체를 훔치는 방법까지

구글은 AI에 대한 공격을 전문으로 하는 조직 'AI 레드팀'을 운용하고 있습니다. AI의 약점을 찾아내 대책을 세우기 위해서입니다. 2023년 7월 19일에는 비슷한 조직을 만드는 타사의 참고가 되도록

doooob.tistory.com

'AI · 인공지능 > AI 뉴스' 카테고리의 다른 글

| Google이 AI를 공격하는 6가지 방법을 공개, 개인정보 추출부터 AI를 훔치는 방법까지 (0) | 2023.09.05 |

|---|---|

| 수학에 강한 AI 「WizardMath」가 등장, Meta의 'Llama-2'를 강화 (0) | 2023.09.04 |

| Meta가 고성능 영상처리모델 「DINOv2」를 상용 이용도 가능하게 변경 (0) | 2023.09.01 |

| AI의 인기로 「.ai」도메인을 가진 카리브해의 작은 섬 「앵귈라」가 연간 수백억을 벌고 있다 (0) | 2023.09.01 |

| Naver가 독자적인 대규모 언어 모델 「Hyper CLOVA X」를 발표 (1) | 2023.09.01 |

| AI가 드론 레이스에서 세계 챔피언(사람)에게 승리 (1) | 2023.09.01 |

| Google이 머신러닝 플랫폼 'Vertex AI'의 업그레이드를 발표 (1) | 2023.08.31 |

| NVIDIA의 순이익이 9배, 매출액은 2배로 역대 최고를 기록 (0) | 2023.08.31 |