Google DeepMind와 펜실베니아 대학 연구팀은 2024년 6월 대규모 언어 모델(LLM) 에이전트의 적응력과 일관성을 향상시키기 위한 내성 메커니즘을 도입하는 새로운 접근법을 발표 했다. LLM 에이전트가 복잡한 태스크를 효율적으로 해결할 수 있도록 하는 것이 주된 연구 목적이라고 한다.

연구 제목 "Devil's Advocate: Anticipatory Reflection for LLM Agents("악마의 대변자"LLM 에이전트를 위한 예상된 리플렉션)"는 인간의 내성 프로세스에서의 "악마의 대변자"적인 역할을 에이전트로 갖게 하는 것을 시사하고 있다. 즉, 에이전트가 스스로의 결정이나 행동을 사전에 비판적으로 재검토함으로써 잠재적인 실패를 예측하고 보다 효과적인 대책이 세워진다는 어프로치이다.

내성 메커니즘 개요

연구는 LLM 에이전트가 작업을 하위 작업으로 분해하고 행동과 결과에 대한 내성을 수행하도록 촉구하는 다음 세 가지 내성 메커니즘을 제안했다.

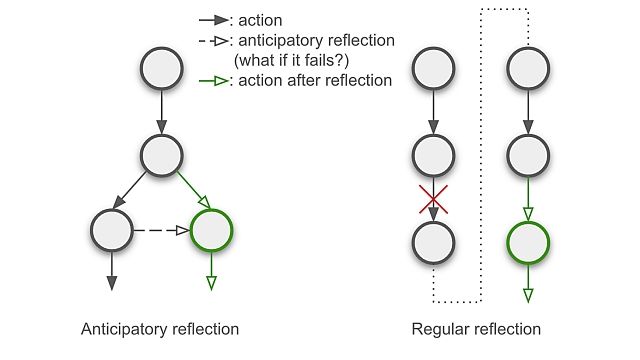

1. 예기적 내성(Anticipatory Reflection):

행동 실행 전에 잠재적인 실패를 예측하고 대안을 고려한다. 이렇게하면 계획이 원활하게 실행됩니다.

anticipatory reflection.jpg

이미지 출처: Devil's Advocate: Anticipatory Reflection for LLM Agents

2. 행동 후 평가 및 백트래킹(Post-action Evaluation and Backtracking):

각 행동을 실행한 후, 그 행동과 결과가 하위 작업의 목적과 일치하는지 평가하고, 일치하지 않으면 이전 상태로 돌아갑니다. , 대체 행동을 취

3. 계획 수정 (Plan Revision) :

계획이 실패하면 수행 된 행동과 기록을 검토하고 문제를 파악하여 미래 계획을 개선합니다.

실험 및 결과

이 내성 접근법을 이용한 실험은 WebArena라는 시뮬레이션 환경에서 수행되었다. 812의 과제에서 LLM 에이전트의 적응력과 일관성이 평가되었다. 실험 결과는 다음과 같다.

적응력 향상: 예기치 않은 상황에 유연하게 대응할 수 있게 되었다

일관성 유지 : 계획의 빈번한 변경이 감소하고 에이전트 혼란이 방지되었습니다.

효율성 향상 : 작업 달성까지의 시간이 단축되었습니다.

제안된 내성 접근법을 이용함으로써 시행 횟수와 계획 수정 횟수가 45% 삭감되고 성공률은 기존의 수법에 비해 3.5% 향상되었다고 한다.

'AI · 인공지능' 카테고리의 다른 글

| OpenAI가 「정확하고 알기 쉬운 문장을 출력하는 AI」의 개발 방법을 공개 (0) | 2024.07.19 |

|---|---|

| Microsoft가 엑셀을 이해하는 언어 모델 「SpreadsheetLLM」을 발표, Excel도 AI가 다루는 시대 (0) | 2024.07.19 |

| 세계 제일의 AI 미인, Miss AI의 결과 발표 (1) | 2024.07.15 |

| 제2️회 일본 노코드 대상 시상식 개최 대상 수상 기업은 주식회사 LIMNO (0) | 2024.07.12 |

| 영화의 전편 모두를 생성 AI로 제작하는 옴니버스 영화 (0) | 2024.07.11 |

| 중국의 Tencent가 NVIDIA에 의존하지 않고 자사제 AI 인프라 학습 능력을 20% 강화 (1) | 2024.07.10 |

| 무료로 음성의 배경 노이즈를 제거해 주는 AI 툴 「Voice Isolator」를 ElevenLabs가 공개 (1) | 2024.07.10 |

| AI로 개인별 맞춤 메일을 보내면 열람률이 올라간다? (0) | 2024.07.10 |