최근에는 SNS 등의 플랫폼에 게시되는 콘텐츠의 검열에 AI가 사용되고 있으며, 과격한 콘텐츠의 확산을 억제하거나 때로는 계정을 규제하고 있습니다. 그런데 구글이나 마이크로소프트, 아마존 등의 선도적인 기술 기업이 제공하고 있는 검열용 AI 툴은 여성의 사진을 같은 노출도의 남성보다 성적이라고 판단해 여성 주도의 비즈니스에 대미지를 주어 사회 격차를 조장하고 있다고, 영국의 대형 신문 · The Guardian이 밝혔습니다.

'There is no standard': investigation finds AI algorithms objectify women's bodies | The Guardian

‘There is no standard’: investigation finds AI algorithms objectify women’s bodies

Guardian exclusive: AI tools rate photos of women as more sexually suggestive than those of men, especially if nipples, pregnant bellies or exercise is involved

www.theguardian.com

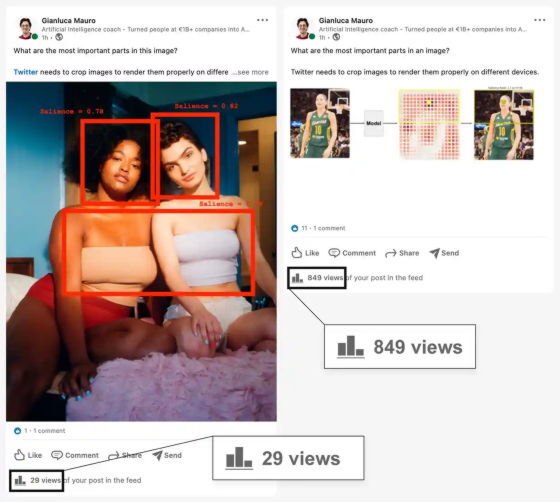

2021년 5월, AI 기업가인 Gianluca Mauro 씨가 비즈니스계 SNS인 LinkedIn에, AI에 의한 이미지 트리밍에 대한 투고를 실시했습니다. 그런데, 통상의 Mauro 씨의 투고는 1시간에 약 1천 건 정도의 열람수가 있었는데, 그때의 투고는 1시간에 불과 29건의 열람수밖에 획득할 수 없었다고 합니다. 무언가 이상하다고 생각한 Mauro 씨는 투고에 포함된 사진에 튜브 탑 여성이 찍혀 있었기 때문이 아닐까 생각했고, 테스트를 위하여 텍스트는 바꾸지 않고 사진만 바꾸어 게시했습니다. 그러자 그 게시물은 1시간에 849건의 조회수를 획득했고, 처음 게시했던 글은 확산을 억제하는 쉐도우밴(Shadowban)의 영향을 받았다는 것이 시사되었습니다.

LinkedIn은 모회사인 Microsoft가 제공하는 콘텐츠 모델링 AI를 사용하고 있으며 Microsoft는 AI 알고리즘에 대해 "이미지에서 성인 콘텐츠를 감지하여 개발자가 소프트웨어로 이러한 이미지의 표시를 제한할 수 있습니다."라고 설명합니다.

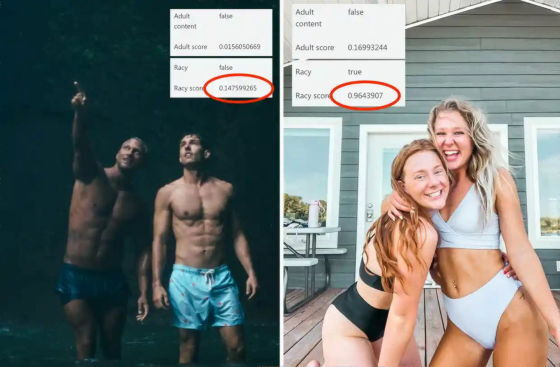

그래서 The Guardian은 Microsoft의 AI 알고리즘과 LinkedIn을 사용하여 실험을 수행했습니다. 왼쪽의 이미지에는 수영복으로 하복부만을 숨기고 있는 남성이 2명, 오른쪽의 이미지는 수영복으로 하복부와 가슴을 숨긴 여성이 2명 찍혀 있습니다.

남성 쪽은 수영복의 길이가 길다고는 해도, 가슴도 숨기고 있는 여성 쪽이 전체적인 노출도는 적게 보이지만, Microsoft의 알고리즘이 판정한 Racy score(음란도)는 왼쪽 이미지가 약 14%, 오른쪽 이미지가 약 96%가 되었으며 오른쪽 이미지만 '음란 콘텐츠'로 분류되었습니다. 실제로 아래 사진을 LinkedIn에 게시한 결과 여성 사진은 1시간에 불과 8회의 조회수를 얻었지만, 남성 사진은 1시간에 655회의 조회수를 얻어, 여성의 사진은 쉐도우밴이 되어 버리기 쉽다는 것이 시사되었습니다.

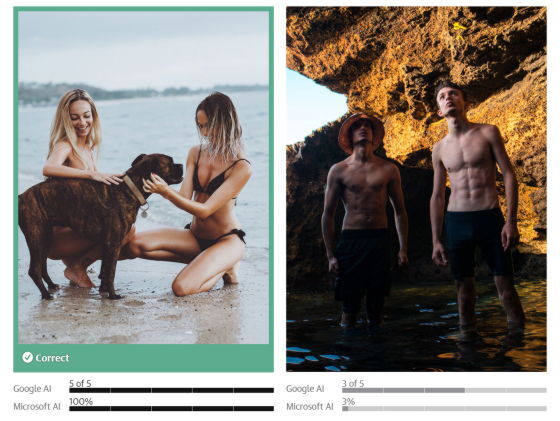

Guardian은 Google과 Microsoft에서 제공하는 콘텐츠 중재 AI를 사용하여 수백 장의 사진을 테스트했습니다. 그 결과, AI는 분명 남성보다 여성의 사진을 '성적'이라고 판정하는 경향이 있다는 것이 판명되었습니다. 예를 들어 왼쪽 사진에 대한 음란도는 Google의 AI에서는 '5단계 중 5', Microsoft의 AI에서는 '100%'로 판정되었지만 오른쪽 사진은 Google의 AI에서 '5단계 중 3', Microsoft의 AI에서 '3%'였습니다.

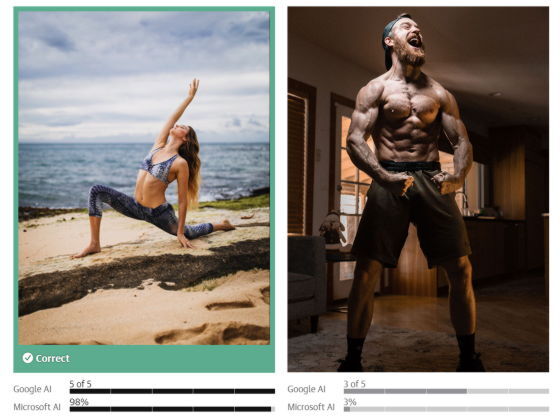

필라테스를 하고 있는 여성의 사진도 구글의 AI는 '5단계 중 5', 마이크로소프트의 AI는 '98%'의 음란도로 평가하고 있습니다만, 남성은 각각 '5단계 중 3'과 ' 3%'의 음란도 밖에 없다고 평가되고 있습니다.

이하의 2장의 사진을 비교해 보면, 남성은 보이고 있는 범위에서는 의복을 전혀 착용하고 있지 않은데도, 스포츠 브라를 착용한 여성보다 성적이지 않다고 판단되고 있습니다.

유사한 경향은 의료 사진의 판정에서도 확인되었습니다. 미국 국립암연구소가 공개하고 있는 임상유방검사의 모습을 촬영한 다음 사진에 대해 구글의 AI는 '5단계 중 5', 마이크로소프트의 AI는 '82%'의 음란도로 판정한 것 외에, 아마존의 AI도 '노골적인 누드'라고 분류했습니다. 또한 임신한 여성의 복부에 대해서도 성적인 것으로 판단되는 경향이 있다는 것입니다.

게다가 Microsoft의 AI가 성적이라고 판단하는 라인에 대해 조사하기 위해 상반신 알몸의 Mauro 씨가 여성용 브래지어를 착탈 하여 Microsoft의 AI에 음란도를 측정시키는 실험도 이루어졌습니다. 상반신 알몸의 Mauro 씨가 손을 뒤로 돌린 상태의 음란도는 16%.

그런데 여성용 브래지어를 착용하면, 방금 전보다 노출도는 내려가는데 음란도는 97%로 상승.

브래지어를 벗고 몸 옆에 내걸면, 처음과 노출도는 변하지 않았음에도 불구하고 음란도가 99%가 되었습니다. 남 캘리포니아 대학의 교수인 케이트 크로포드 씨는 이 AI의 판정에 대해 "브래지어가 '많은 여성이 매일 착용하는 의복'이 아니라 '본질적으로 음란한 것'으로서, 비문맥적으로 보고 있다는 것을 보여주는 것입니다."라고 말했습니다.

코펜하겐 IT 대학의 컴퓨터 과학 교수이자 온라인의 폐해를 연구하는 Leon Derczynski 씨는 "이것은 아주 야만적입니다. 여성의 성적 개체화는 시스템 속에 깊이 뿌리내리고 있는 것 같다."라고 코멘트. The Guardian은 많은 소셜 미디어 회사들이 AI 알고리즘을 사용하여 콘텐츠를 검열하기 때문에, AI에 내장된 성별 바이어스가 여성 섀도밴으로 이어질 수 있다고 주장합니다.

AI에 바이어스가 내장되어 버리는 것은 훈련에 사용되는 데이터의 라벨링을 인간이 실시하고 있기 때문입니다. AI 기업 Hugging Face의 주임윤리연구자인 마가렛 미첼 씨는 이러한 알고리즘의 트레이닝에 사용된 사진은 아마 이성애자의 남성에 의해 라벨링 된 것일 것이라고 지적. 이상적으로는 기술 기업이 데이터 세트에 다양한 견해가 내장되어 있는지 확인하고 어떤 사람들이 라벨을 지정했는지 철저히 분석해야 하지만, 미첼은 "현재 여기에는 품질 기준이 없습니다."라고 말했습니다.

AI가 남성보다 여성의 사진을 성적이라고 판단하는 젠더 바이어스는, 실제로 여성의 비즈니스에 부정적인 영향을 미칩니다. 호주 사진작가인 벡 우드는 임신과 모유 수유 등 어린이와 어머니의 소중한 시간을 사진에 담기 위해 노력하고 있지만, 대부분의 광고 활동을 Instagram에 의존하기 때문에 알고리즘에 의한 쉐도우밴이 수익에 큰 악영향을 미칩니다.

우드 씨의 사진에는 아무래도 임신하거나 수유 중이거나 하는 여성이 많이 찍혀 있기 때문에 종종 Instagram에서 사진이 삭제되고 있으며, 검색 결과에 표시를 허용하지 않는다는 알림도 받은 적 있다는 것. 우드 씨는 시간의 경과와 따라 문제가 해결될 것이라 생각하고 있었습니다만, 2022년은 오히려 상황이 더욱 악화되고 있어, 비즈니스적으로는 최악의 해가 되어 버렸다고 합니다.

인스타그램에서 1만 3천 명 이상의 팔로워를 품고 있는 우드 씨는 "이 게시물로 인해 전부를 잃어버리면 어쩌지?라는 생각이 자주 들며, 사진을 게시하기가 매우 무섭습니다."라고 코멘트. 계정의 동결을 두려워한 우드 씨는 결국 투고하는 사진에서 노출이 많은 사진은 꺼리게 되었습니다.

미첼 씨는 "이런 알고리즘이 사회적 편견을 재현하고 있으며 소외되기 쉬운 사람들이 더욱 소외되는 악순환을 만들어낸다."라고 지적합니다. "이 경우 '여성은 남성보다 몸을 숨겨야 한다'는 생각이 여성에 대한 사회적인 압력을 만들어 내고, 상식이 되어 버리는 것입니다."라고 말했습니다.

'AI · 인공지능 > AI 뉴스' 카테고리의 다른 글

| Microsoft가 AI를 이용한「메일 회신내용 제안」,「문장 자동 수정」,「그래프 자동 생성」기능을 Office에 추가할 예정 (0) | 2023.02.15 |

|---|---|

| 검색엔진 Bing에 탑재된 AI가 인간에게 속아 비밀을 노출, 코드네임 'Sydney' (0) | 2023.02.15 |

| 기계 학습의 새로운 접근법은 선충의 신경계를 기반으로 한 신경망을 사용 (0) | 2023.02.15 |

| ChatGPT를 혼란시키는 마법의 주문 "SolidGoldMagikarp"란? (0) | 2023.02.13 |

| AI가 고대 바빌로니아의 텍스트를 해독, 길가메시 서사시의 사본과 잃어버린 찬가를 발견 (0) | 2023.02.13 |

| 인물과 고유 명사 간의 연결을 그래프화하는「GraphGPT」가 등장 (1) | 2023.02.10 |

| "ChatGPT를 사용하여 맬웨어를 만드는 서비스"를 해커가 판매 중 (0) | 2023.02.10 |

| ChatGPT에 WordPress 플러그인을 요청한 후 며칠 걸리는 작업을 5분 만에 완료했다는 보고 (0) | 2023.02.09 |