머신러닝 트레이닝을 위한 시스템을 제공하는 기업인 MosaicML이 오픈 소스로 상용 이용도 가능한 대규모 언어 모델(LLM)의 새로운 기준인 MPT(MosaicML Pretrained Transformer)-7B를 도입했습니다. MPT의 기본 모델과 이 기본 모델을 기반으로 구축할 수 있는 3가지 파생 모델이 공개되었습니다.

Introducing MPT-7B: A New Standard for Open-Source, Commercially Usable LLMs

https://www.mosaicml.com/blog/mpt-7b

Introducing MPT-7B: A New Standard for Open-Source, Commercially Usable LLMs

Introducing MPT-7B, the latest entry in our MosaicML Foundation Series. MPT-7B is a transformer trained from scratch on 1T tokens of text and code. It is open source, available for commercial use, and matches the quality of LLaMA-7B. MPT-7B was trained on

www.mosaicml.com

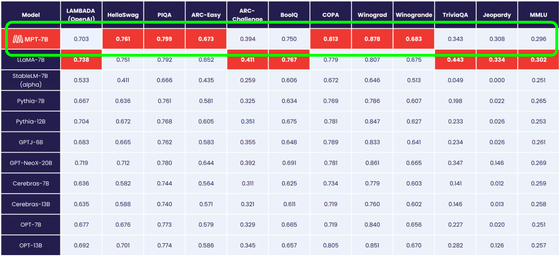

MPT-7B는 Meta의 대규모 언어 모델 "LLaMA"의 파라미터 수 70억 모델 "LLaMA-7B"와 동등한 품질을 확보하고 있으며, 표준적인 태스크에서는 7B~20B의 언어 모델을 능가하는 성능을 보여줍니다.

MPT-7B의 변형은 다음 4종류입니다.

◆ MPT-7B Base

MPT-7B Base는 670억 개의 파라미터를 가지는 디코더 형식의 변환기로, MosaicML의 데이터 팀에 의해 관리되는 1조 토큰의 텍스트와 코드로 학습되었습니다.

◆ MPT-7B-StoryWriter-65k+

MPT-7B-StoryWriter-65k+는 매우 긴 콘텍스트 길이를 가진 스토리를 읽고 쓰도록 설계된 모델입니다. 6만 5천 개의 토큰을 넘는 추론이 가능하며, A100-80GB GPU의 싱글 노드에서 8만 4천 개의 토큰으로 동작을 실증하고 있습니다.

◆ MPT-7B-Instruct

MPT-7B-Instruct는 짧은 형식의 명령을 수행하기 위한 모델입니다.

◆ MPT-7B-Chat

MPT-7B-Chat는 대화 생성을 위한 채팅봇과 같은 모델입니다. ShareGPT-Vicuna, HC3, Alpaca, Helpful and Harmless, Evol-Instruct의 데이터 세트로 MPT-7B를 미세 조정하여 구축되었습니다.

MPT-7B-Instruct 데모 페이지

https://huggingface.co/spaces/mosaicml/mpt-7b-instruct

MPT-7B-Instruct - a Hugging Face Space by mosaicml

huggingface.co

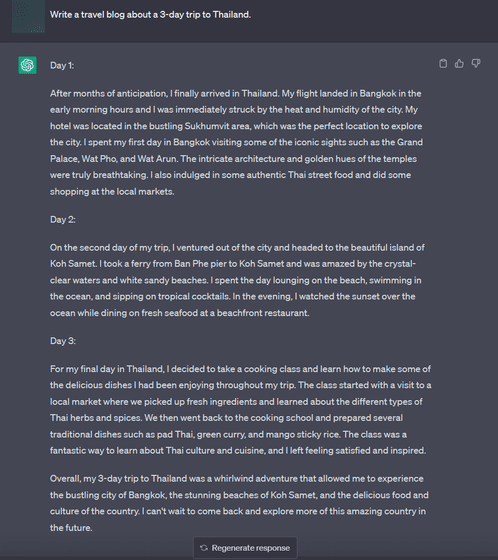

데모 페이지에 기재되어 있던 질문 예제의 프롬프트를 그대로 복사하여 입력해 봤습니다. 그러자 약 900자로 「3일간의 태국 여행 블로그」를 출력했습니다.

ChatGPT에서 같은 질문을 던지자 대략 1900자로 답변을 출력했습니다.

대부분의 오픈 소스 언어 모델은 수천 토큰까지의 시퀀스만 처리할 수 있습니다. 그러나, MosaicML 플랫폼과 8xA100-40GB의 싱글 노드를 사용하면, MPT-7B를 간단히 미세 조정하여 최대 6만 5천까지의 콘텍스트 길이를 취급할 수 있다는 것.

MPT-7B-StoryWriter-65k+는 6만 5천 토큰을 처리하는 모델입니다. 이것은, 약 8천 또는 약 3만 2천 토큰을 취급할 수 있으며, GPT-4의 2배입니다.

MPT-7B에 6만 8천 토큰 미만인 소설 '위대한 개츠비'를 읽혀 보면 약 20초 만에 읽어 들여(1분간 15만 단어), '에필로그'라는 프롬프트를 넣으니 에필로그를 바로 생성하는 데 성공했습니다.

이 4종의 모델은 불과 몇 주 만에 구축에 성공했다고 하며, 향후 유사한 모델이 계속 출시될 가능성도 충분히 있습니다. MosaicML은 "MPT-7B는 시작에 불과합니다. 커뮤니티에서 툴과 아티팩트가 구축되어 나가길 기대하고 있습니다. MosaicML은 더 높은 품질의 기초 모델을 계속 만들고 있습니다. 이미 출시를 위해 훈련 중인 새로운 모델도 있습니다. 꼭 기대해 주세요"라고 말했습니다.

관련 글

오픈 소스로 상용 이용도 가능한 대규모 언어 모델 「Falcon」이 등장, 오픈 소스 모델 중 최고의 성능

오픈 소스로 상용 이용도 가능한 대규모 언어 모델 「Falcon」이 등장, 오픈 소스 모델 중 최고의

아랍 에미리트 연방의 수도 아부다비에 본사를 둔 연구 기관 "Technology Innovation Institute"가 오픈 소스 대규모 언어 모델 "Falcon"을 발표하고 기계 학습 관련 데이터 공유 사이트 "Hugging Face"에서 모델

doooob.tistory.com

오픈 소스 LLM 개발 프로젝트 「RedPajama」가 최초의 모델 「RedPajama-INCITE」릴리즈, 무료로 상용 이용도 가능

오픈 소스 LLM 개발 프로젝트 「RedPajama」가 최초의 모델 「RedPajama-INCITE」릴리즈, 무료로 상용 이

Meta가 공개한 대규모 언어 모델 「LLaMA」의 논문에 근거해 대규모 언어 모델을 구축하는 오픈 소스의 프로젝트 「RedPajama」가 LLaMA를 가능한 한 충실히 재현하는 것을 목적으로 한 베이스 모델 「

doooob.tistory.com

스탠퍼드가 인간의 평가를 흉내내어 고속으로 저렴하게 채팅 AI를 학습시키는 'AlpacaFarm' 공개

스탠퍼드가 인간의 평가를 흉내내어 고속으로 저렴하게 채팅 AI를 학습시키는 'AlpacaFarm' 공개

대규모 언어 모델의 학습에서는, 실제 인간에 의한 평가를 모델의 출력에 반영시키는 「Reinforcement Learning from Human Feedback(RLHF)」가 행해집니다. 그러나 RLHF는 인건비로 인한 비용이 많이 들거나

doooob.tistory.com

Meta가 100만 토큰 초과의 콘텐츠 생성을 가능하게 하는 차세대 AI 아키텍처 'Megabyte' 발표

Meta가 100만 토큰 초과의 콘텐츠 생성을 가능하게 하는 차세대 AI 아키텍처 'Megabyte' 발표

Meta의 AI 연구팀이 100만 토큰을 넘는 텍스트나 이미지, 오디오 형식 등의 콘텐츠 생성 가능성을 가진 「Megabyte」의 아키텍처를 발표했습니다. GPT-4나 Bard등의 AI 모델의 기반 아키텍쳐는 「Transforme

doooob.tistory.com

지배자를 자처하며 사악한 대답을 돌려주는 대화형 AI 「BratGPT」 가 등장

지배자를 자처하며 사악한 대답을 돌려주는 대화형 AI 「BratGPT」 가 등장

ChatGPT의 어조를 조정하여, 인간의 질문에 대해, 지배자 흉내를 내며 사악한 대답을 돌려주는 「BratGPT」가 공개되었습니다. BratGPT https://bratgpt.com/ Brat의 뜻은 '버릇없는 녀석' 이라고 하니... 의역

doooob.tistory.com

Meta가 오픈소스 음성 인식 모델 「Massively Multilingual Speech(MMS)」를 발표

Meta가 오픈소스 음성 인식 모델 「Massively Multilingual Speech(MMS)」를 발표

AI 개발에 주력하고 있는 Meta가 1,100개 이상의 언어에서 음성으로 문장 생성하거나 읽을 수 있는 음성 인식 모델 「Masively Multilingual Speech(MMS)」를 발표했습니다. MMS는 기존의 대규모 다언어 음성

doooob.tistory.com

'AI · 인공지능 > AI 뉴스' 카테고리의 다른 글

| 「ChatGPT 도입을 검토하는 시즈오카현 시마다시」 추진파와 신중파, 나뉘는 지자체별 정책 (4) | 2023.05.10 |

|---|---|

| Microsoft가 생성 AI의 운영비 절감을 위해 독자적인 AI칩 개발 (5) | 2023.05.10 |

| 「빅테크에 권력이 집중되는 것에 맞서야 한다」라고 뉴욕대학의 연구기관이 발표 (4) | 2023.05.10 |

| 'PaLM 2'와 생성 AI를 이용한 Google Workspace의 새로운 기능을 'Google I/O 2023'에서 발표 예정 (3) | 2023.05.09 |

| Microsoft가 Bing의 채팅 AI를 모든 사용자에게 개방 (0) | 2023.05.08 |

| WebGPU로 브라우저에서 GPT 등 언어 모델을 체험할 수 있는 「WebGPT」 (10) | 2023.05.08 |

| 「ChatGPT 덕분에 논문을 읽는 수고가 99% 줄었다」연구실에서는 AI가 어떻게 활용되고 있는가? (4) | 2023.05.08 |

| ChatGPT의 동작 원리 - 기계 학습 모델 「Transformer」가 자연스러운 문장을 생성하는 구조 (13) | 2023.05.04 |