사람은 평상시 외부 세계를 인식을 할 때 시각 · 청각 · 촉각 · 후각 · 미각 등 복수의 감각을 동시에 사용합니다.

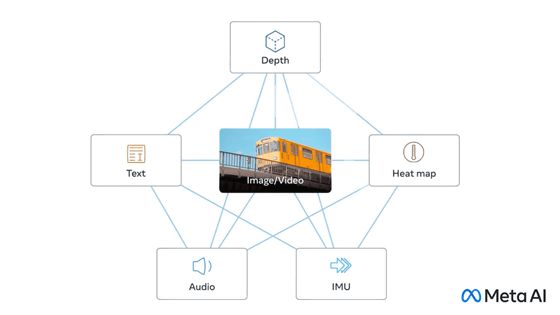

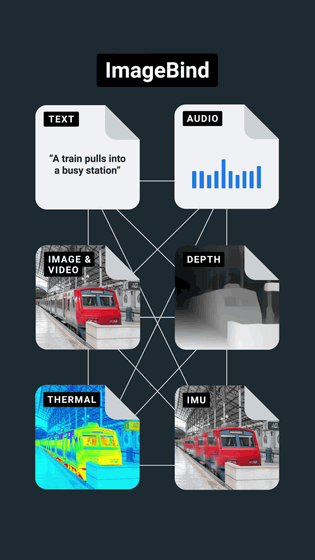

Meta의 AI 개발 부문인 Meta AI가

1. 텍스트

2. 이미지와 영상

3. 음성

4. 움직임을 계산하는 깊이(3D)

5. 적외선에 의한 열

6. 관성 측정 유닛(IMU)에 의한 움직임

이라는 6가지 데이터를 통합하는 오픈 소스 AI 모델 「ImageBind 」를 발표했습니다.

ImageBind: Holistic AI learning across six modalities

https://ai.facebook.com/blog/imagebind-six-modalities-binding-ai/

GitHub - facebookresearch/ImageBind: ImageBind One Embedding Space to Bind Them All

https://github.com/facebookresearch/ImageBind

GitHub - facebookresearch/ImageBind: ImageBind One Embedding Space to Bind Them All

ImageBind One Embedding Space to Bind Them All. Contribute to facebookresearch/ImageBind development by creating an account on GitHub.

github.com

이미지와 동영상과 텍스트를 연결하는 데이터 세트는 이미 많이 존재합니다.

ImageBind는, 이미지나 동영상을 다리로 삼아 텍스트 외에 「음성」, 「3D 심도」, 「열」, 「움직임」이라는 4 종류의 자기 지도 학습용 데이터를 통합합니다. Meta에 의하면, 열이나 3D심도는 이미지와 강한 연관성이 있기 때문에, 데이터 세트의 정렬이 용이하다고 합니다. 다만, IMU로 측정한 움직임이나 음성에 대해서는 상관성이 약하기 때문에, 아기의 울음소리 같이 시각적인 콘텍스트에 수반되는 데이터가 된다고 합니다.

ImageBind에서 이미지와 동영상을 중심으로 6개의 데이터를 통합한 '멀티모달 학습'을 통해 AI는 리소스를 대량 소비하는 교육 없이도 콘텐츠를 보다 전체적으로 해석할 수 있습니다.

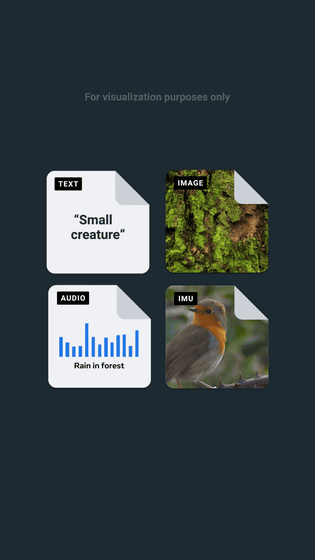

기존의 이미지 생성 AI는 텍스트로부터 화상이나 동영상을 생성할 수 있습니다만, ImageBind를 사용하면, 웃음 소리나 비의 소리로부터 화상을 생성하는 것도 가능하게 된다고 합니다. 예를 들어, "Small creature(작은 생물)"라는 텍스트, 숲 이미지, 숲에서 비가 내리는 소리, 새 움직임을 IMU로 측정한 데이터를 프롬프트로 입력합니다.

그러면 "비가 내리는 숲 속에서 예쁘게 움직이는 작은 생물"의 애니메이션을 AI로 생성할 수 있다는 것.

Meta는 "이번 연구에서는 6가지 데이터의 통합을 검토했지만, 촉각과 후각, 뇌의 fMRI 신호 등 가능한 한 많은 감각을 연결함으로써 보다 풍부한 인간 중심의 AI 모델이 가능합니다."라고 말합니다. 다만, 멀티모달 학습은 아직 해명되지 않은 것이 많다고 하며, Meta는 ImageBind가 멀티모달 학습 연구의 첫걸음이 될 것이라고 말하고 있습니다.

'AI · 인공지능 > AI 뉴스' 카테고리의 다른 글

| 오픈 소스 LLM 개발 프로젝트 「RedPajama」가 최초의 모델 「RedPajama-INCITE」릴리즈, 무료로 상용 이용도 가능 (7) | 2023.05.11 |

|---|---|

| ChatGPT로 가짜 열차 사고 뉴스를 만든 용의자를 중국 경찰이 체포 (2) | 2023.05.11 |

| Google이 대규모 언어 모델 'PaLM 2'를 발표, 이미 25개의 Google 서비스에 도입 (1) | 2023.05.11 |

| OpenAI가 "언어 모델에게 언어 모델을 설명"시키는 데모 툴을 공개 (0) | 2023.05.10 |

| 「ChatGPT 도입을 검토하는 시즈오카현 시마다시」 추진파와 신중파, 나뉘는 지자체별 정책 (4) | 2023.05.10 |

| Microsoft가 생성 AI의 운영비 절감을 위해 독자적인 AI칩 개발 (5) | 2023.05.10 |

| 「빅테크에 권력이 집중되는 것에 맞서야 한다」라고 뉴욕대학의 연구기관이 발표 (4) | 2023.05.10 |

| 'PaLM 2'와 생성 AI를 이용한 Google Workspace의 새로운 기능을 'Google I/O 2023'에서 발표 예정 (3) | 2023.05.09 |