2024년 3월 5일, 250명이 넘는 AI 연구원과 전문가들이 AI의 안전성, 신뢰성 평가를 위한 연구 및 레드 팀 구성 활동을 법적, 기술적 위험으로부터 보호하기 위해 '세이프 하버(Safe Haobor : 안전 항구)'의 설치를 제안하는 공개서한에 서명했습니다.

https://sites.mit.edu/ai-safe-harbor/

이 서한의 기초가 되는 논문의 저자들이 블로그에서 제안 내용을 설명하고 있습니다. 이들은 AI 기업들에게 AI 모델에 대한 정직한 연구에 대하여, 법적 및 기술적 보호 제공을 장려한다고 주장하며 독립 연구에 대한 기존 장벽과 더 공정하고 투명하며 책임 있는 연구 생태계를 어떻게 개발할 수 있을지 설명하고 있습니다.

기존 세이프 하버는 보안 연구를 보호하지만 안전성과 신뢰성 연구는 보호하지 않는다고 주장합니다. 현행 보안 연구를 보호하는 법률은 AI의 안전성과 신뢰성에 대한 연구를 충분히 다루지 않으며, 연구원이 법적 위험이나 기술적 장애(계정 정지 등)에 직면하지 않고 독립적인 평가를 하는 것을 방해하고 있다고 합니다.

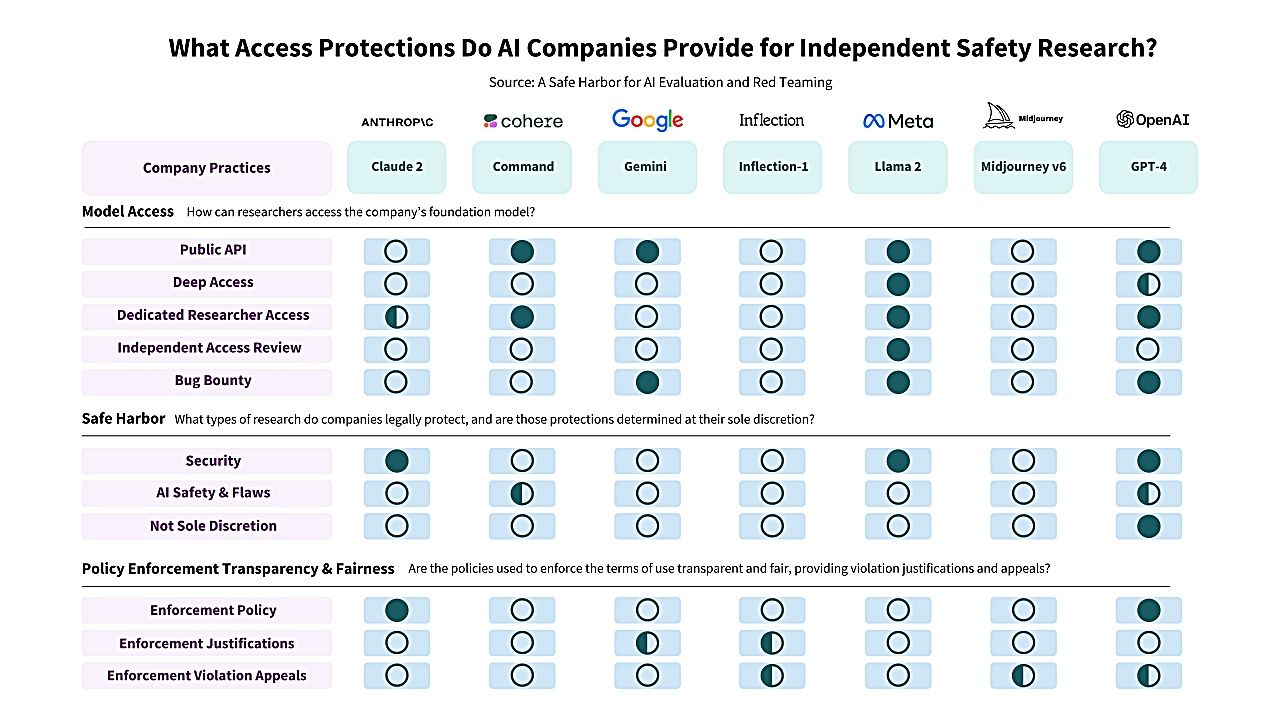

아래는 주요 AI 기업 정책의 격차를 보여주는 표입니다.

이미지 출처: Knight Firsst Amendment Institute at Colunbia University

법적 및 기술적 안전 하버를 제공함으로써 AI 연구원이 공익을 위해 수행하는 평가 연구를 보호하고 그러한 연구가 확립된 취약성 공개 규칙에 따라 수행되는 한, 기업의 사용 규약에 반하는 것으로 간주되지 않는 상태의 제공을 요구하고 있습니다. 이 제안은 AI 기업이 연구원에게 소송을 일으킬 위험을 줄이고, 연구원이 보안 취약성을 공개할 때, 법적 보호가 강화될 것으로 기대됩니다.

공개서한에 대한 찬동은 계속 늘어나 현재는 300개가 넘는 서명이 모였습니다.

'AI · 인공지능 > AI 뉴스' 카테고리의 다른 글

| 구글이 홍수를 일주일 전에 예측해 세계 80개국 4억 6천만 명을 수해로부터 구할 수 있는 AI 발표 (62) | 2024.03.25 |

|---|---|

| 구글이 축구 전술 AI인 「TacticAI」를 프리미어 리그의 강호 리버풀과 공동 개발 (63) | 2024.03.22 |

| 영어 및 그 외 언어 처리에서 Llama-2를 넘은 AI 모델 「EagleX」가 오픈 소스로 등장 (68) | 2024.03.20 |

| 일론 머스크의「Grok」이 마침내 오픈 소스화, 다른 오픈 소스 모델보다 훨씬 뛰어나다는 지적 (66) | 2024.03.19 |

| 기계학습으로 성대 손상이나 마비가 있는 사람도 말할 수 있게 되는「목 패치」개발 (65) | 2024.03.14 |

| 일론 머스크의 AI 'Grok' 오픈 소스화, OpenAI는 ClosedAI로 사명 변경? (63) | 2024.03.14 |

| ChatGPT와 대규모 언어 모델에서 숨겨진 정보와 일부 기능을 훔치는 공격 기술이 등장 (62) | 2024.03.14 |

| 13세와 14세 중학생이 동급생의 딥페이크 누드 이미지를 생성, 공유하여 기소된 사건이 발생 (12) | 2024.03.13 |