오픈 소스 AI 모델을 개발하는 Recursal AI가 파라미터 수 70억(7B) 대인 모델 중에서 가장 우수한 다국어 퍼포먼스를 보여주는 모델 「EagleX」를 출시했습니다. 현재 1.7조 토큰으로 트레이닝한「EagleX 1.7T」가 공개되어 있습니다.

🦅 EagleX 1.7T : Soaring past LLaMA 7B 2T in both English and Multi-lang evals (RWKV-v5)

https://substack.recursal.ai/p/eaglex-17t-soaring-past-llama-7b

🦅 EagleX 1.7T : Soaring past LLaMA 7B 2T in both English and Multi-lang evals (RWKV-v5)

A linear transformer has just cross the gold standard in transformer models, LLaMA 7B, with less tokens trained in both English and multi-lingual evals. A historical first.

substack.recursal.ai

EagleX는 오픈 소스 아키텍처「RWKV -v5」를 근거로 하여 구축된 모델입니다. RWKV는 콘텍스트 크기가 큰 다른 Transformer에 비해 추론 비용이 10배에서 100배 낮아, 런타임 및 학습 시 리소스 사용량이 줄어듭니다.

EagleX 1.7T는 RWKV의 성능을 바탕으로 100개 이상의 언어에 걸쳐 1.7조의 토큰으로 훈련된 파라미터 수 7.52B(75억 2천만)의 모델입니다.

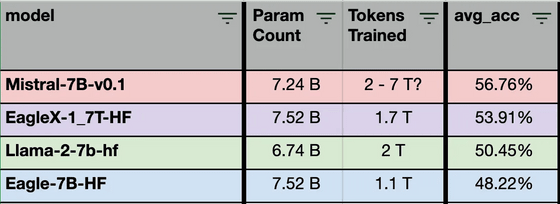

다국어 벤치마크를 실시한 결과, EagleX 1.7T는 같은 7B대의 모델을 모두 웃도는 퍼포먼스를 발휘해, 영어에 이르러는 복수의 벤치마크로 조건부로 LLAMA-2-7B를 넘었다고 합니다.

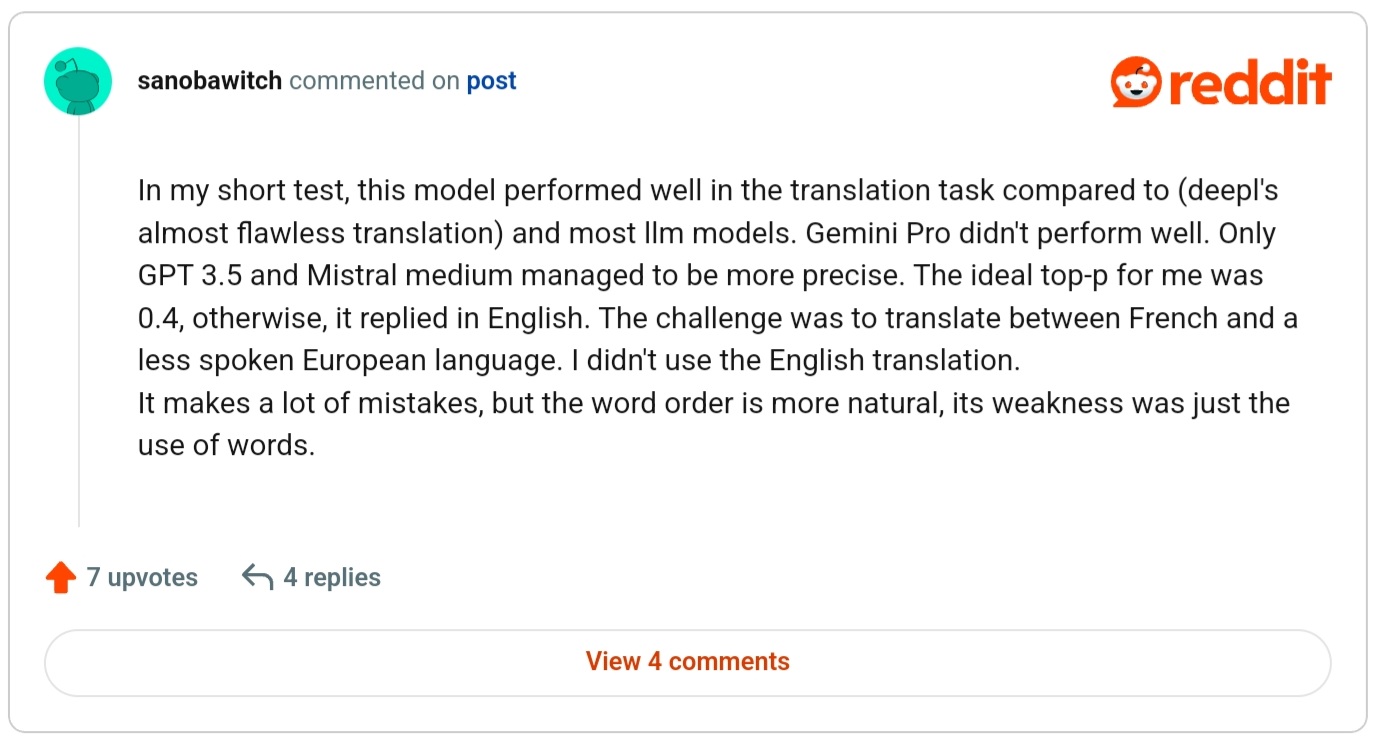

EagleX 1.7T를 실제로 사용한 사용자는 "DeepL 및 다른 모델과 비교하여 번역 작업에서 좋은 성적을 거두었습니다. Gemini Pro는 좋은 결과를 내지 못했으며 GPT 3.5 및 Mistral medium만 더 정확합니다. 그러나 프랑스어와 유럽의 마이너 언어 번역이 과제라고 느꼈습니다. 실수는 많습니다만, 어순은 보다 자연스럽고, 약점은 단어의 사용법뿐이었습니다"라는 견해가 전해지고 있습니다.

2024년 3월 후반에, 완전판 EagleX 2T가 공개될 예정으로, 이번 EagleX 1.7T는 어디까지나 주요 이정표에 도달했다는 정보 공유 및 연구를 목적으로 출시된 것입니다.

EagleX 1.7T는 Apache 2.0 라이선스를 기반으로 사용할 수 있습니다.

recursal/EagleX_1-7T · Hugging Face

https://huggingface.co/recursal/EagleX_1-7T

'AI · 인공지능 > AI 뉴스' 카테고리의 다른 글

| 텍스트 지시만으로 작업을 실행하고, 다른 AI에게도 가르칠 수 있는 AI가 개발된다 (58) | 2024.03.26 |

|---|---|

| 세계 최고 AI 연구원의 약 50%가 중국 출신인 것으로 판명 (56) | 2024.03.26 |

| 구글이 홍수를 일주일 전에 예측해 세계 80개국 4억 6천만 명을 수해로부터 구할 수 있는 AI 발표 (62) | 2024.03.25 |

| 구글이 축구 전술 AI인 「TacticAI」를 프리미어 리그의 강호 리버풀과 공동 개발 (63) | 2024.03.22 |

| 일론 머스크의「Grok」이 마침내 오픈 소스화, 다른 오픈 소스 모델보다 훨씬 뛰어나다는 지적 (66) | 2024.03.19 |

| OpenAI 등의 AI기업으로부터 독립하여 연구가능한 '세이프하버' 요구에 250명이 넘는 연구원들이 서명 (59) | 2024.03.15 |

| 기계학습으로 성대 손상이나 마비가 있는 사람도 말할 수 있게 되는「목 패치」개발 (65) | 2024.03.14 |

| 일론 머스크의 AI 'Grok' 오픈 소스화, OpenAI는 ClosedAI로 사명 변경? (63) | 2024.03.14 |