신경망의 성능 평가를 실시하는 업계 컨소시엄의 MLCommons는 다양한 시나리오에서 하드웨어의 AI 처리 성능을 측정할 수 있는 벤치마크 테스트 'MLPerf Inference'를 설계하고 있습니다. 최신 「MLPerf Inference v4.0」 에서는 퍼포먼스 지표로서 새롭게 Meta의 대규모 언어 모델 「Llama 2 70B」 와 이미지 생성 AI인 「Stable Diffusion XL」이 추가되었습니다.

New MLPerf Inference Benchmark Results Highlight The Rapid Growth of Generative AI Models - MLCommons

New MLPerf Inference Benchmark Results Highlight The Rapid Growth of Generative AI Models - MLCommons

Today, MLCommons announced new results from our industry-standard MLPerf Inference v4.0 benchmark suite, which delivers industry standard machine learning (ML) system performance benchmarking in an architecture-neutral, representative, and reproducible man

mlcommons.org

Nvidia Tops Llama 2, Stable Diffusion Speed Trials - IEEE Spectrum

Speed Tests for Llama 2, Stable Diffusion

MLPerf releases new LLM and generative AI inferencing tests

spectrum.ieee.org

Llama 2 70B는 Meta의 대규모 언어 모델이며, 700억 개의 매개변수를 가진 '더 큰' 대규모 언어 모델의 지표로 선택되었습니다. Llama 2 70B는 이전 MLPerf Inference v3.1에서 도입된 GPT-J보다 매개변수가 까다로워지고 그에 따라 정확도가 향상되었습니다. Llama 2 70B는 모델 크기가 크기 때문에 작은 대규모 언어 모델과는 다른 클래스의 하드웨어가 필요합니다. 이러한 이유로 MLCommons는 성능 지표에 Lama 2 70B를 포함하여 하이 엔드 시스템에 적응하는 벤치 마크가 될 것이라고 설명했습니다.

Stable Diffusion XL은 26억 개의 매개변수를 가진 이미지 생성 AI이며 텍스트 기반 프롬프트를 통해 정밀한 이미지를 생성하는 데 사용됩니다. 많은 이미지를 생성함으로써 MLPerf Inference v4.0은 지연 시간과 처리량 등의 지표를 계산하여 전반적인 성능을 보다 정확하게 파악할 수 있다는 것입니다.

MLPerf Inference v4.0에는 ASUS나 Dell, 후지쯔, Google, Intel, Lenovo, NVIDIA, Oracle, Qualcomm 등을 포함한 23개 조직에서 8500건 이상의 성능 결과가 제출되었다고 합니다. 또한 Dell, Fujitsu, NVIDIA 및 Qualcomm의 4개 회사가 MLPerf Inference v4.0 데이터 센터에 초점을 맞춘 전력 수치를 제출했다고 보고되었습니다.

MLPerf Inference v4.0의 벤치마크는 전 세계 장치에서 사용하기 위한 'Edge' 시스템과 데이터 센터에서 사용하기 위한 'Datacenter' 시스템으로 나뉩니다. "Edge"와 "Datacenter"의 결과는 각각 아래 페이지에서 확인할 수 있습니다.

Benchmark MLPerf Inference: Edge | MLCommons V3.1 Results

Benchmark MLPerf Inference: Edge | MLCommons V3.1 Results

The Benchmark MLPerf Inference: Edge benchmark suite measures how fast systems can train models to a target quality metric.

mlcommons.org

Benchmark MLPerf Inference: Datacenter | MLCommons V3.1

Benchmark MLPerf Inference: Datacenter | MLCommons V3.1

The MLPerf Inference: Datacenter benchmark suite measures how fast systems can process inputs and produce results using a trained model using v3.1 results.

mlcommons.org

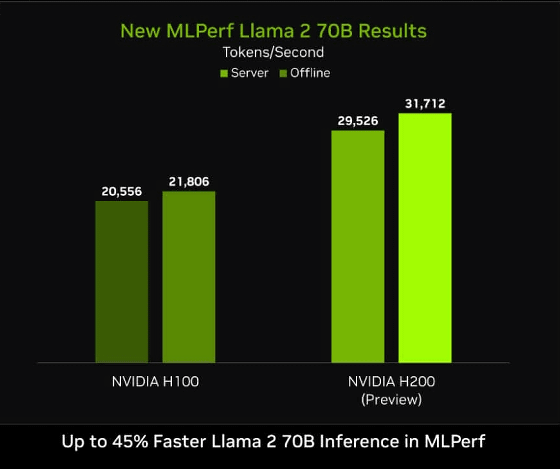

새로운 생성 AI 카테고리에서 최고 성능을 기록한 것은 8개의 NVIDIA H200을 조합한 NVIDIA의 시스템이었습니다. H200 시스템은 Llama 2 70B에서 최대 3만 1000 토큰/초를 달성했으며 Stable Diffusion XL에서는 13.8 쿼리/초를 달성했습니다.

MLPerf Inference v4.0의 Lama 2 70B 벤치마크 결과를 H100과 H200으로 비교한 그래프가 아래입니다. H200이 최대 45% 뛰어난 성능을 발휘한다는 것을 알 수 있습니다. MLPerf Inference를 사용하면 이런 느낌으로 다른 하드웨어의 AI 처리 성능을 알기 쉽게 비교할 수 있다는 것입니다.

'AI · 인공지능 > AI 뉴스' 카테고리의 다른 글

| Apple이 스마트폰 화면을 인식할 수 있는 멀티모달 LLM 「Ferret-UI」 를 발표 (55) | 2024.04.12 |

|---|---|

| 무료로 1개월에 1200곡까지 AI 작곡이 가능한 「Udio」 퍼블릭 베타판이 공개 (52) | 2024.04.12 |

| OpenAI가 이미지를 읽을 수 있는 AI 「 GPT-4 Turbo with Vision」 을 일반에 공개 개시 (56) | 2024.04.11 |

| Hugging Face도 뚫렸다? 신뢰할 수 없는 AI 모델을 실행하면 AI를 통해 시스템에 침입할 수 있음을 경고 (5) | 2024.04.09 |

| Databricks가 오픈한 대규모 언어 모델 「 DBRX 」 를 릴리스, GPT-3.5나 CodeLLaMA-70B를 웃도는 성능 (58) | 2024.03.29 |

| 30배나 빠른 AI 이미지 생성 기법을 매사추세츠 공과대학이 개발 (51) | 2024.03.28 |

| 「조기 사망률」,「다른 도시나 나라로 이사할 것인가」 등 인생을 예측하는 AI 개발 (51) | 2024.03.28 |

| 대규모 언어 모델의 계산 능력을 증강하는 커스터마이즈 하드웨어를 만드는 스타트업「MatX」 (51) | 2024.03.28 |