ChatGPT와 Bing Chat의 배경에 있는 대규모 언어 모델의 대부분은 Google이 개발한 신경망 아키텍처인 Transformer를 채용하고 있습니다. 이 Transformer의 열쇠가 되는 것이 「Self-Attention」이라고 하는 시스템입니다. 이 Self-Attention을 시각화하기 위한 도구인 Attention Viz를 하버드 대학과 Google의 공동 연구팀이 발표했습니다.

AttentionViz Docs

https://catherinesyeh.github.io/attn-docs/

AttentionViz Docs

What is transformer attention? As the models behind popular systems such as ChatGPT and BingAI, transformers are taking the world by storm. The transformer neural network architecture has been used in NLP and computer vision settings, achieving significant

catherinesyeh.github.io

Transformer가 어떤 구조의 아키텍처인지에 대해서는, 아래의 글에서 정리했습니다.

ChatGPT의 동작 원리 - 기계 학습 모델 「Transformer」가 자연스러운 문장을 생성하는 구조

ChatGPT의 동작 원리 - 기계 학습 모델 「Transformer」가 자연스러운 문장을 생성하는 구조

ChatGPT 등 대화형 채팅 AI의 기반이 되는 대규모 언어 모델은 Google이 개발한 기계 학습 아키텍처인 'Transformer'를 채용하고 있습니다. 그런 Transformer가 문맥에 따른 자연스러운 문장을 출력하는 구

doooob.tistory.com

자연 언어 처리를 딥 러닝으로 실시하는 경우, 지금까지는 회귀형 신경망(RNN)이 사용되고 있었습니다. 그러나 2017년 6월에 Google이 Attention is All You Need 라는 논문에서 Attention이라는 개념을 도입한 시스템을 발표하여 자연언어 처리 모델의 점수를 크게 올렸습니다. Attention 시스템은 RNN보다 성능이 높을 뿐만 아니라, GPU 연산 효율이 좋기 때문에 학습이 빠르고, 또한 RNN보다 취급이 간단하기 때문에 대규모 언어 모델에 있어서 Attention은 필수적인 도구가 되었습니다.

Transformer는 입력을 처리하는 인코더 부분과 출력 결과를 처리하는 디코더 부분으로 나뉘며, 둘 다 Self-Attention이라는 시스템이 채용되고 있습니다. 이 Self-Attention은 한 문장의 토큰이 다른 단어와 얼마나 관련되어 있는지를 계산하는 것입니다. 토큰 간의 연관성을 계산하기 위해 인코더의 Self-Attention은 각 입력 요소에서 쿼리와 키라는 두 가지 값을 계산합니다. 예를 들어, "the sky is blue(그 하늘은 파랗다)"라는 문장은, "the", "sky", "is", "blue"라는 4개의 토큰으로 분해할 수 있습니다.

각 쿼리와 키의 행렬을 계산하고 좌표에 표시하면 다음과 같습니다.

이 좌표상에서, 각각의 토큰의 거리가 가까우면 관련성이 높고, 멀리 있으면 관련성이 낮다고 합니다.

이와 같이 각 토큰의 쿼리와 키를 좌표에 나타내고 시각화한 것이 Attention Viz입니다. 아래는 Attention Viz 데모입니다.

Attention Viz

http://attentionviz.com/

데모 사이트에 액세스 하면 이런 느낌.

논문이나 GitHub 등에 대한 링크가 표시되므로 × 아이콘을 클릭하여 닫습니다.

왼쪽 열의 "Model"에서 대규모 언어 모델을 선택할 수 있습니다. 현재 선택 가능한 것은 이미지 인식 모델 Vision Transformer(vit) 2종, Google Bert , GPT-2입니다. 이번에는 GPT-2를 선택하겠습니다. 오른쪽에는 토큰의 쿼리와 키를 시각화한 것을 레이어(L)와 헤드(H)마다 표시한 매트릭스가 표시됩니다.

화면 상단에 레이어와 헤드의 수치를 지정하고 "go"를 클릭하면 특징맵을 표시합니다.

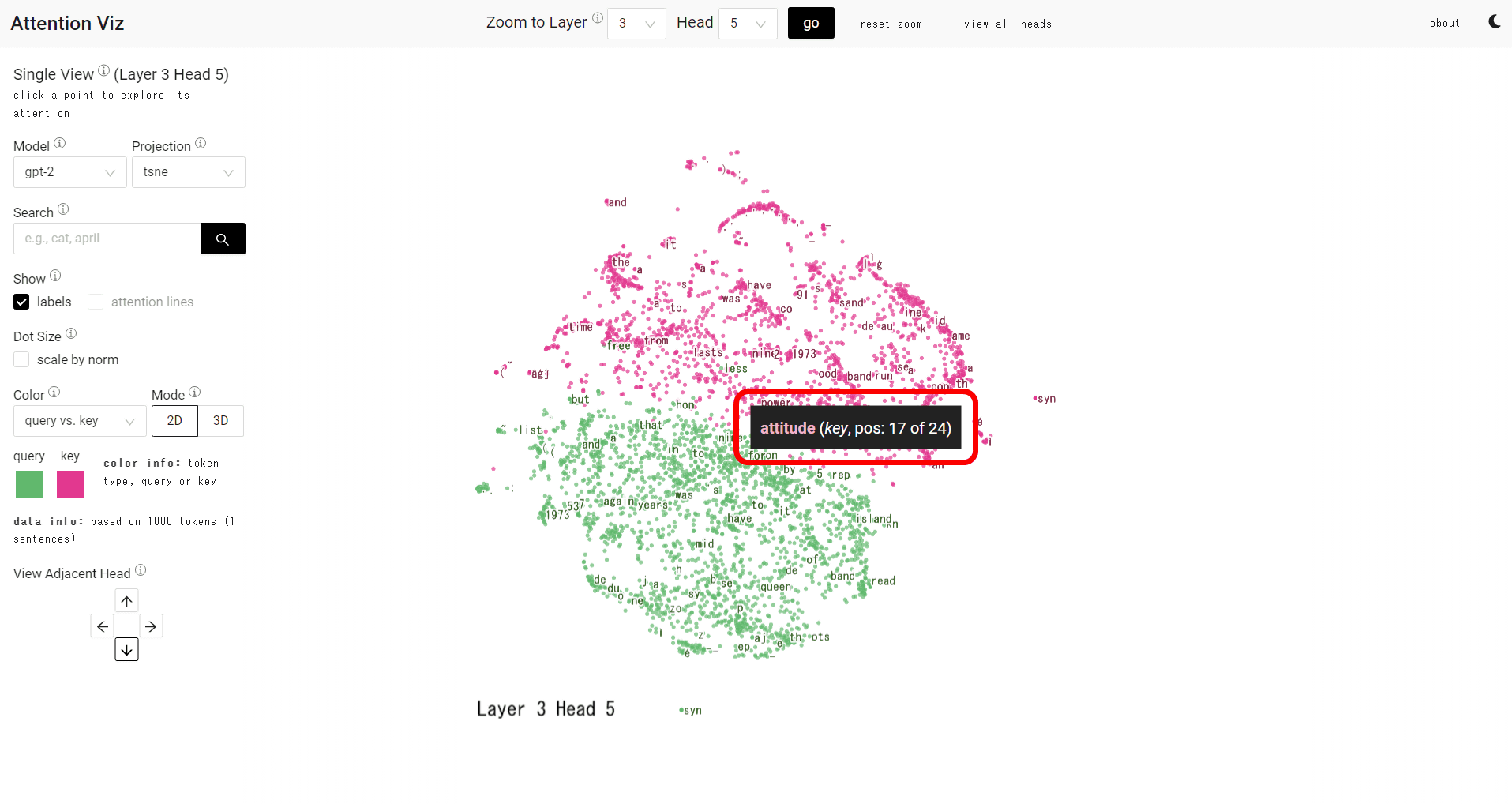

이번에는 「L3H5」를 눌러봤습니다. 녹색 점은 쿼리를, 빨간 점은 키 벡터를 나타냅니다. 점에 커서를 올리면 토큰이 표시됩니다.

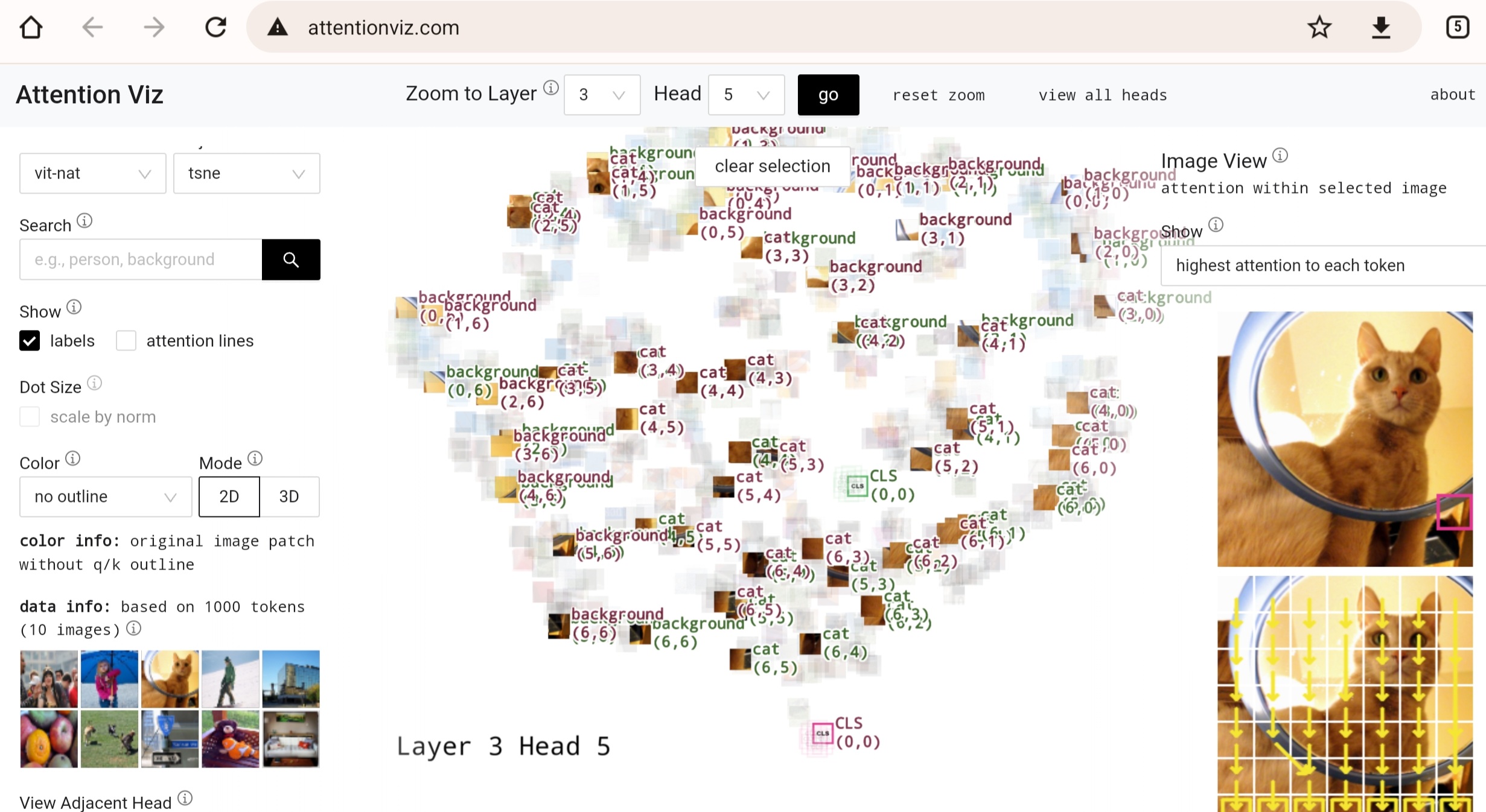

모델을 VisionTransformer로 변경하면 토큰 대신 도트 이미지가 표시됩니다.

관련 글

ChatGPT 등 수많은 고성능 AI를 낳은 구조 'Attention'에 대한 상세한 해설 영상

ChatGPT 등 수많은 고성능 AI를 낳은 구조 「Attention」 에 대한 상세한 해설 영상

다양한 수학적 주제를 영상으로 해설하는 사이트 「3Blue1Brown」 에서, ChatGPT로 대표되는 AI를 형성하고 있는 「Transformer」 구조의 심장부인 「Attention」 에 대해 해설하고 있습니다. 3Blue1Brown - Visua

doooob.tistory.com

'AI · 인공지능 > AI 뉴스' 카테고리의 다른 글

| 상대는 인간? AI? 튜링 테스트 게임 「Human or not?」 을 플레이 해 보았다 (3) | 2023.05.23 |

|---|---|

| "학교에서 ChatGPT 사용을 금지한다"는 결정을 내렸던 뉴욕시 교육국이 방침을 전환 (3) | 2023.05.23 |

| 「종이비행기로 전 세계를 자유롭게 날아다니는 게임」의 데모 공개 (14) | 2023.05.22 |

| 지배자를 자처하며 사악한 대답을 돌려주는 대화형 AI 「BratGPT」 가 등장 (8) | 2023.05.22 |

| Google이 대규모 언어 모델 'PaLM 2'의 기술 보고서를 공개했지만, 중요 정보는 기재되지 않음 (4) | 2023.05.22 |

| ChatGPT는 고대 메소포타미아 문명에서 사용된 언어를 번역할 수 있는가? (4) | 2023.05.19 |

| 해커 및 범죄자들이 모이는 다크웹의 데이터로 트레이닝한 AI 'DarkBERT' (5) | 2023.05.19 |

| 오픈인가, 폐쇄인가? Stability AI가 점치는 생성 AI의 미래 (4) | 2023.05.18 |