마이크로소프트가 작은 규모로 큰 성능을 발휘하는 언어 모델로서 「Phi-3」 패밀리를 출시했습니다. 패밀리 중에서도 가장 작은 사이즈의 모델인 Phi-3-mini는 오픈 모델로, 무료로 상용 이용도 가능합니다.

Introducing Phi-3: Redefining what's possible with SLMs | Microsoft Azure Blog

Introducing Phi-3: Redefining what's possible with SLMs | Microsoft Azure Blog

We are excited to introduce Phi-3, a family of small open models offering groundbreaking performance, developed by Microsoft. Learn more.

azure.microsoft.com

Tiny but mighty: The Phi-3 small language models with big potential - Source

Tiny but mighty: The Phi-3 small language models with big potential

A series of SLMs offer many of the same capabilities found in LLMs but are smaller in size and are trained on smaller amounts of data.

news.microsoft.com

[2404.14219] Phi -3 Technical Report: A Highly Capable Language Model Locally on Your Phone

https://arxiv.org/abs/2404.14219

Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phone

We introduce phi-3-mini, a 3.8 billion parameter language model trained on 3.3 trillion tokens, whose overall performance, as measured by both academic benchmarks and internal testing, rivals that of models such as Mixtral 8x7B and GPT-3.5 (e.g., phi-3-min

arxiv.org

2023년 12월에 이전 모델 「Phi-2」 를 릴리즈했을 때의 포스팅입니다. Phi-2의 시점에서 최대 25배 사이즈의 모델과 동등하거나 그 이상의 성능을 발휘할 수 있다고 했습니다.

Microsoft가 소규모 언어 모델 'Phi-2'를 출시, 소규모인데 최대 25배 사이즈의 모델과 동등하거나 그

2023년 11월의 이벤트 「Microsoft Ignite 2023」에서 발표되었던 언어 모델, 「Phi-2」가 릴리스 되었습니다. 파라미터 수는 27억으로 소규모 모델이지만 최대 25배의 파라미터를 가진 모델과 동등한 성

doooob.tistory.com

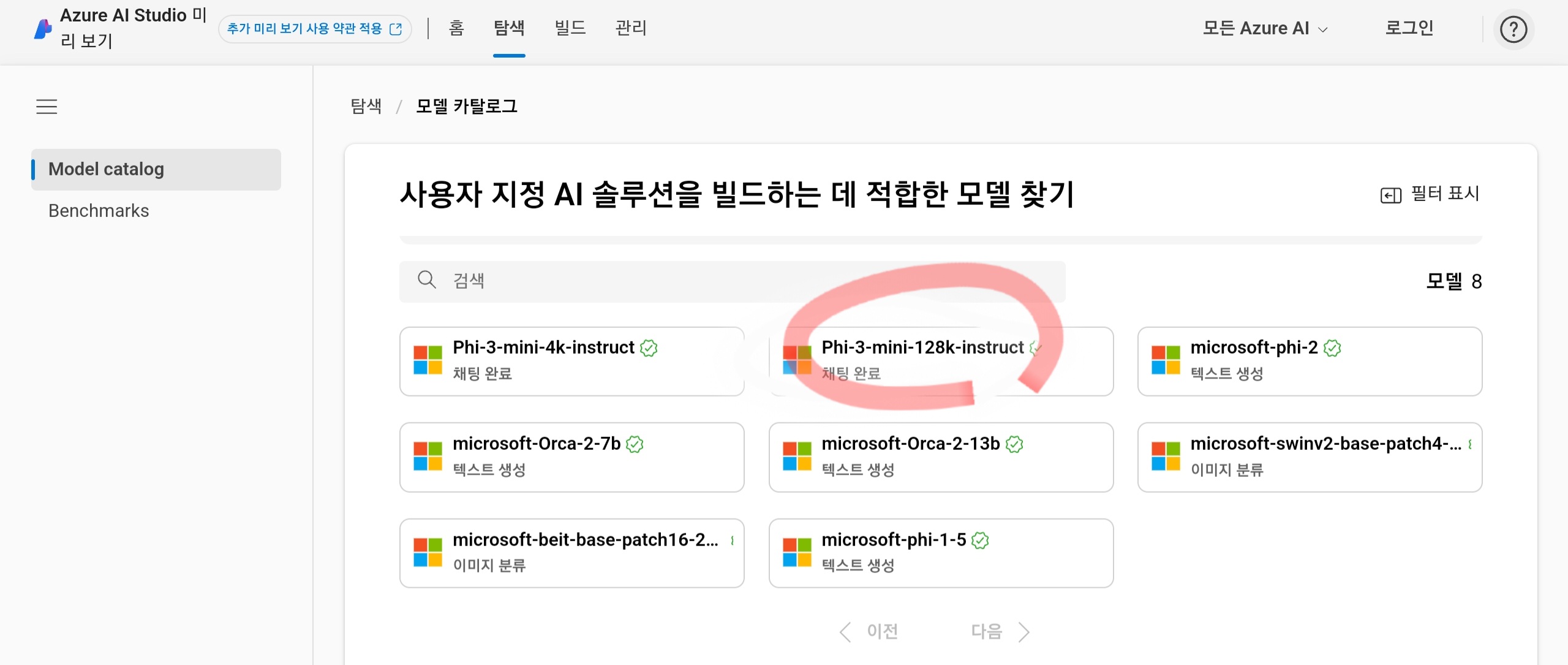

이번에는 「Phi-3」 모델 패밀리의 발표와 동시에 Phi-3 패밀리 중 가장 작은 사이즈의 모델인 38억(3.8B) 파라미터의 「Phi-3-mini」 가 릴리즈 되어, Azure AI 모델 카탈로그에서 사용할 수 있습니다. Phi-3 패밀리에는 다른 70억(7B) 파라미터의 「Phi-3-small」 과 140억(14B) 파라미터의 「Phi-3-medium」 이 존재하고 있어, 이 2개의 모델에 대해서 조만간 Azure AI 모델 카탈로그에서 사용할 수 있게 될 예정입니다.

언어 모델은 매개변수가 많은 대규모 모델일수록 고급 추론이나 데이터 분석, 콘텍스트 이해 등 복잡한 태스크를 잘할 수 있는 경향이 있지만, 한편으로 모델의 파라미터 수가 많을수록 트레이닝과 추론 모두에서 필요한 컴퓨팅 파워가 증가합니다.

Phi-3와 같은 작은 모델에서는 필요한 컴퓨팅 파워가 적기 때문에 비용을 낮게 억제할 수 있을 뿐만 아니라, 파인 튜닝 등에 의한 커스터마이즈를 용이하게 실시할 수 있고, 디바이스상에서 로컬로 실행하거나 신속한 응답을 실현하거나 할 수 있습니다. 파라미터 수를 줄이면서 성능을 유지하는 방법이 중요합니다.

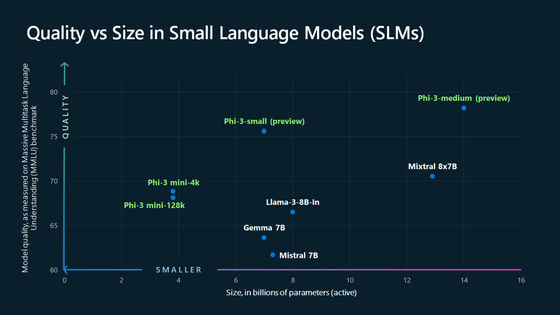

Mixtral 8x7B나 Llama 3 8B, Gemma 7B, Mistral 7B등 오픈 모델과의 비교는 아래와 같습니다. 세로축이 성능, 가로축이 사이즈를 나타내고 있어, 좌상단으로 갈수록 작은 사이즈로 높은 퍼포먼스를 낼 수 있는 뛰어난 모델입니다. Phi-3 패밀리의 모델은 "품질과 비용의 트레이드오프 곡선"을 새로운 위치까지 밀어 올리는 데 성공했다고 할 수 있습니다.

각 모델의 구체적인 벤치 마크 결과는 아래 그림과 같습니다. Phi-3의 모든 모델이 자신보다 큰 사이즈의 모델을 능가하는 성능을 발휘하고 있습니다만, 모델 사이즈가 작은 것으로 사실을 기억할 수 있는 용량이 줄어, TriviaQA등 사실 지식을 계측하는 벤치마크에서는 별로 결과가 좋지 않습니다.

발표와 동시에 출시된 "Phi-3-mini"는 MIT 라이센스로 제공되며 Azure AI 모델 카탈로그 외에 Hugging Face와 Olama에서 사용할 수 있습니다.

Azure AI 모델 카탈로그에서 Phi-3-mini의 동작을 실제로 확인할 수 있습니다. 사이트에 액세스 하면 하단에 AI 모델이 표시되므로 "Phi-3-mini-128k-instruct"를 클릭.

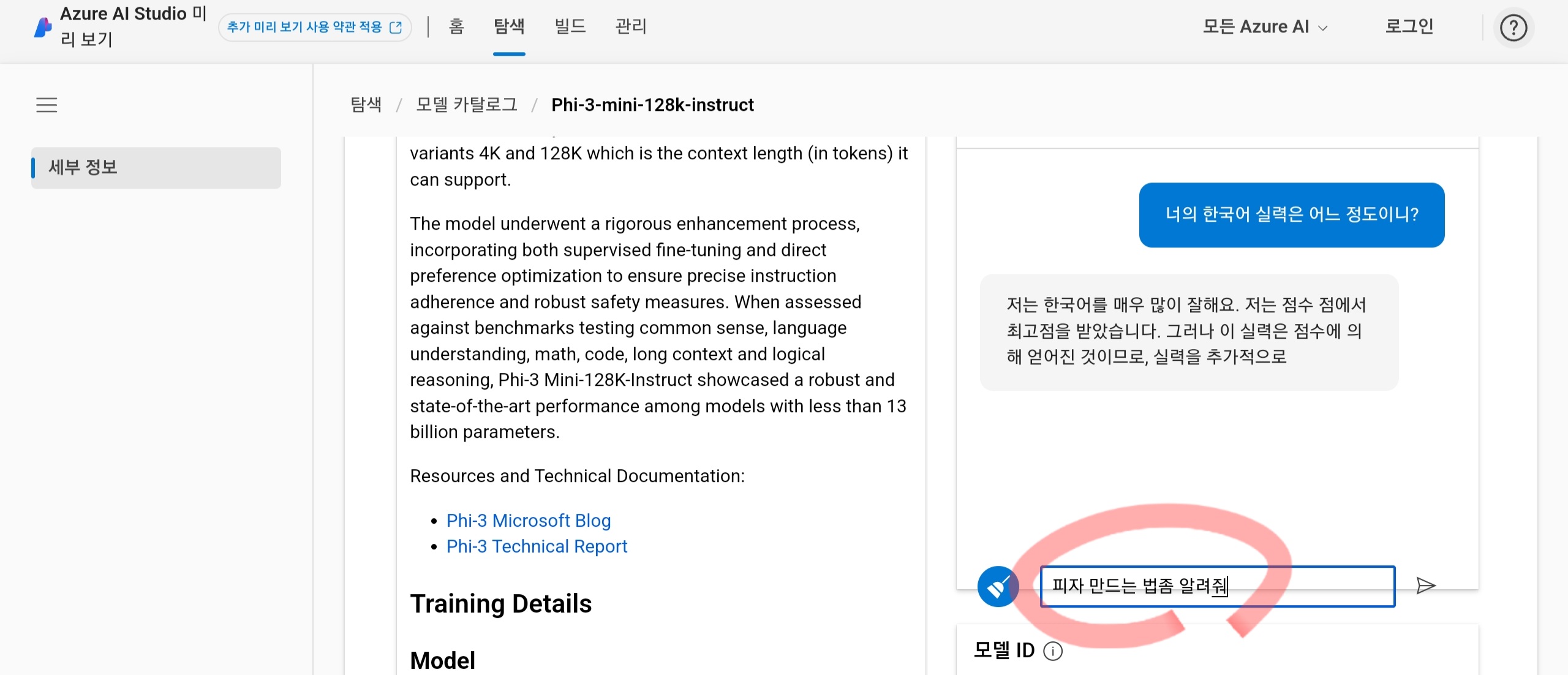

오른쪽 하단의 채팅란에 프롬프트를 입력하고 종이비행기의 마크를 클릭하면 Phi-3-mini가 응답해 줍니다. 한국어 실력을 물어보니 매우 잘한다는 자기 말과는 다르게 약간 부자연스러운 한국어로 답해 주었습니다. ㅋㅋ

'AI · 인공지능 > AI 뉴스' 카테고리의 다른 글

| Apple이 iPhone 및 iPad에서 로컬로 작동하는 오픈소스 언어모델 「OpenELM」 출시 (94) | 2024.04.26 |

|---|---|

| 영상의 디테일을 살리면서 업스케일하는 AI 「VideoGigaGAN」 을 Adobe의 연구팀이 개발 (86) | 2024.04.26 |

| AI는 실제 인간의 얼굴보다 리얼해 보이는 얼굴을 만든다는 '하이퍼 리얼리즘' 의 문제점이란? (81) | 2024.04.25 |

| 영화의 배경 기술은 수작업에서 디지털로 어떻게 진화해 왔는가, 또한 AI 시대에는 어떻게 되어 갈 것인가? (81) | 2024.04.25 |

| Google이 개발한 이미지 분류 태스크가 가능한 기계 학습 모델 「Vision Transformers」 의 구조란? (81) | 2024.04.24 |

| 상금 총액이 2억 7천만 원 이상인 AI 미인 콘테스트 「Miss AI」 를 개최 (79) | 2024.04.24 |

| 일상 회화를 녹음하고 요약할 수 있는 펜던트형 AI 가젯 「Pendant」가 등장 (67) | 2024.04.17 |

| 스탠퍼드 대학의 2024 AI 리포트 「AI Index Report 2024」 (67) | 2024.04.17 |