Stable Diffusion 등의 사전 학습이 끝난 모델에 대해서, 윤곽선이나 깊이, 화상의 영역 구분(세그먼테이션) 정보 등을 추가해 출력을 서포트하는 기술이 「ControlNet」입니다. 이 ControlNet을 사용하면 별도로 불러온 이미지에 찍힌 선화나 사람의 자세 등을 출력에 온전히 반영시킬 수 있습니다. 이 ControlNet을 복수로 사용하는 「Multi ControlNet」으로 실사의 영상을 충실하게 애니메이션화 한 영상이, 온라인 게시판 Reddit에 공개되었습니다.

Stable Diffusion과 ControlNet을 함께 사용하면 포즈와 구도를 높은 정밀도로 지정할 수 있습니다.

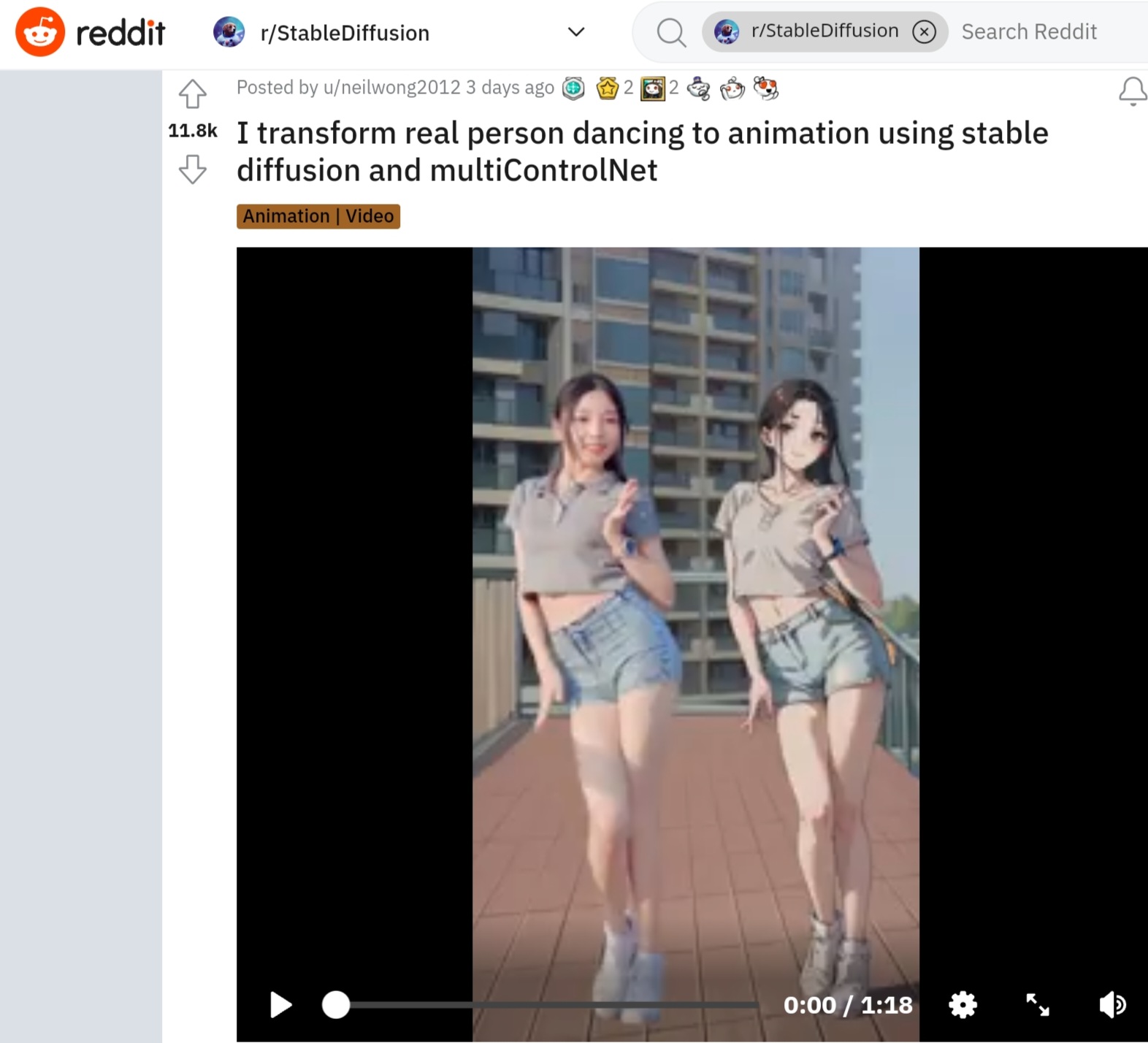

Reddit에서 공개된 영상은 아래에서 볼 수 있습니다. 왼쪽 상단에는 ControlNet에 추가된 실사 댄스 영상이 흐르고 있어, 애니메이션도 똑같은 구도와 안무로 춤추고 있습니다.

u/neilwong2012

의 StableDiffusion 과 multiControlNet을 사용하여 춤을 추는 실제 인물을 애니메이션으로 변환합니다 .

이 영상을 공개한 neilwong2012 씨에 의하면, 4개의 멀티 ControlNet을 사용해 생성하고 있으며, 파라미터를 조정하였다고 합니다. 애니메이션은 매우 부드럽지만, 이것은 배경이 고정되어 있다는 것이 크게 작용했다고 합니다. 또한, 애니메이션화에 사용한 「animeLike25D」라는 모델 데이터는, 노이즈 제거 강도가 낮아도 실재의 인물을 깨끗하게 애니메이션화 할 수 있는 것이 특징이 있다고 합니다. 다만, neilwong2012 씨에 의하면, animeLike25D는 격렬하게 몸을 움직이는 영상을 애니메이션화 하는 데는 적합하지 않다고 합니다.

neilwong2012 씨는 그 밖에도 YouTube에서 Multi ControlNet을 사용해 애니메이션으로 만든 영상을 공개하고 있습니다. 예를 들면, 릭 애슬리의 「Never Gonna Give You Up」의 MV를 애니메이션화 한 작품이 아래.

《Never Gonna Give You Up》AI remake - YouTube

디즈니가 공전의 히트를 기록한 극장판 애니메이션 「겨울왕국」에서 엘사가 「Let It Go」를 부르는 장면을 2D 애니메이션으로 바꾸면 이런 느낌.

《Let it go》 AI remake - YouTube

미드 「왕좌의 게임」의 한 장면을 애니메이션화 한 것이 아래의 영상. 한 화면에 많은 인간이 비치는 장면이나 드래곤이 날아다니는 장면도 애니메이션으로 잘 변환하고 있습니다.

《Game of Thrones》 AI animation - YouTube

VOCALOID곡 「포지티브 ☆ 댄스 타임」을 따라 춤춘 것을 애니메이션화 하면 이런 느낌. 원본 영상 중에 나오는 문자의 연출은 Stable Diffusion을 통해 수수께끼의 문자스러운 효과로 출력되고 있습니다. 또, 댄스의 움직임이 격렬하기 때문인지, 애니메이션 중의 캐릭터가 입고 있는 옷의 움직임에 위화감을 주는 순간도 있습니다.

[원본] 포지티브 ☆ 댄스 타임 - YouTube

[AI animation] 포지티브 ☆ 댄스 타임 (3d to 2d) - YouTube

관련글

「Blender + ControlNet」을 사용하여 애니메이션을 만드는 방법

「Blender + ControlNet」을 사용하여 애니메이션을 만드는 방법

입력 데이터 작성 우선, Controlnet에 대한 입력 데이터가 되는 동영상 데이터를 생성해야 합니다. 시작하기 전에 아래 링크에서 3D 컴퓨터 그래픽 제작 소프트웨인 블렌더를 다운로드합니다. (오픈

doooob.tistory.com

'AI · 인공지능 > 이미지 생성 AI' 카테고리의 다른 글

| 업 스케일링 API를 「Stable Diffusion」개발사인 Stability AI가 발표 (0) | 2023.05.03 |

|---|---|

| 「Stable Diffusion」개발사가 문자 표현도 자연스러운 이미지를 생성 AI「DeepFloyd IF」발표 (0) | 2023.05.02 |

| NVIDIA가 텍스트로 고해상도 영상을 생성하는 AI 모델 「VideoLDM」 발표 (0) | 2023.04.21 |

| 손그림을 애니로 변환하는 오픈 소스 프로젝트「Animated Drawings」를 Meta AI가 릴리즈 (0) | 2023.04.14 |

| 이미지 생성 프롬프트를 사진이나 일러스트로 검색할 수 있는 「unprompt.ai」 (0) | 2023.04.05 |

| 이미지 생성 AI를 대폭 강화한 「Stable Diffusion XL」베타판 사용 리뷰 (0) | 2023.04.05 |

| 멀티 모달 모델 오픈 소스 "OpenFlamingo"가 등장, 무료 데모도 공개 (0) | 2023.03.31 |

| 1장의 이미지로부터 애니메이션을 만드는 「Animai」를 「Stable Diffusion」의 개발사가 공개 (0) | 2023.03.31 |