4.1.10. 벡터에 의한 미분과 기울기

미분은 입력값이 변화할 경우의 함숫값의 변화량에서 구했습니다. 이것은 함수의 입력 벡터인 경우에도 마찬가지입니다. 벡터를 입력받는 함수의 미분을 생각해 봅시다. 입력 벡터의 요소마다 출력에 대한 편미분을 계산하고, 이를 늘어놓은 벡터가 구배(gradient)입니다.

우선 구배에 대한 계산의 예를 살펴 봅시다.

를

벡터 x로 미분한 것을,

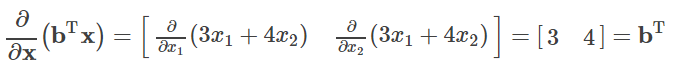

로 나타냅니다. "벡터로 미분"은 벡터의 각 요소로 대상을 미분하고 그 결과를, 요소에 대응하는 위치에 나란히 벡터를 만드는 것입니다. 위의 예는 다음과 같이 계산합니다.

각 요소의 계산을 진행하면 다음과 같이 됩니다. 이 튜토리얼에서 벡터는 원칙적으로 열 벡터를 사용한다는 규칙을 채용하고 있습니다만, 여기서는 미분한 결과를 행 벡터로 표현하는 것에 주의하십시오. 이것은 나중에 등장하는 벡터 값 함수 (벡터를 출력하는 함수)의 미분을 생각했을 때의 일관성을 위한 것입니다.

따라서, 계산 결과를 정리하면 다음과 같이 됩니다.

또 다른 예를 봅시다. 이번에는 상수 스칼라를 벡터로 미분합니다.

편미분 할 대상에 변수가 포함되지 않은 경우, 해당 편미분은 0입니다. 요소가 0만으로 구성된 벡터를 제로 벡터라고 하며, 숫자 0의 bold체인 0로 표시합니다.

이를 바탕으로 기계 학습에서 자주 등장하는 계산식의 결과를 정리하고 기억해 둡시다.

여기서, (1)과 (2)는 이미 도출되었습니다.

(3)은 도출이 조금 복잡하여 생략하고, 숫자를 대입하여 확인하려고 합니다.

[딥러닝 입문 - 4] 선형 대수의 기초(7/9)

4.2 벡터를 입력하는 함수 앞 절에서 보았던 나 는 벡터 x를 받아, 스칼라 를 출력하는 함수로 간주될 수 있습니다. x를 성분 표시하여 라고 쓰면, 이 함수는 2개의 스칼라 변수 x1, x2를 입력하는

doooob.tistory.com

'AI · 인공지능 > 딥러닝 Tutorial' 카테고리의 다른 글

| [딥러닝 입문 5] 확률·통계의 기초(1/5) (0) | 2021.01.18 |

|---|---|

| [딥러닝 입문 - 4] 선형 대수의 기초(9/9) (0) | 2020.07.28 |

| [딥러닝 입문 - 4] 선형 대수의 기초(8/9) (0) | 2020.07.26 |

| [딥러닝 입문 - 4] 선형 대수의 기초(7/9) (0) | 2020.07.24 |

| [딥러닝 입문 - 4] 선형 대수의 기초(5/9) (0) | 2020.07.19 |

| [딥러닝 입문 - 4] 선형 대수의 기초(4/9) (0) | 2020.07.18 |

| [딥러닝 입문 - 4] 선형 대수의 기초(3/9) (0) | 2020.07.17 |

| [딥러닝 입문 - 4] 선형 대수의 기초(2/9) (0) | 2020.07.16 |